-

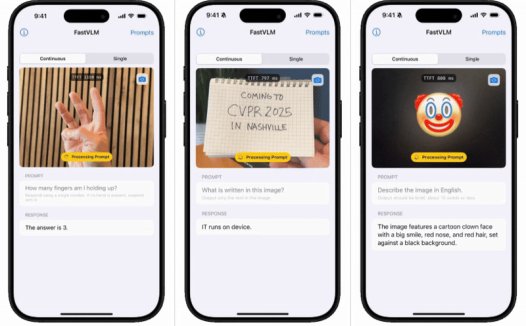

苹果 FastVLM 模型开放试用:Mac 用户秒享“闪电级”视频字幕,生成速度较同类 AI 快 85 倍

9 月 2 日消息,科技媒体 9to5Mac 昨日(9 月 1 日)发布博文,报道称苹果公司在 Hugging Face 平台上,推出了 FastVLM 视觉语言模型的浏览器试用版。 注:FastVLM 以其“闪电般”的视频字幕生成速度著称,只要用户拥有搭载 Apple Silicon 芯片的 Mac 设备,即可轻松上手体验这一前沿技术。 FastVLM 模型的核心优势在于其卓越的速度和效率。该模…- 2.2k

-

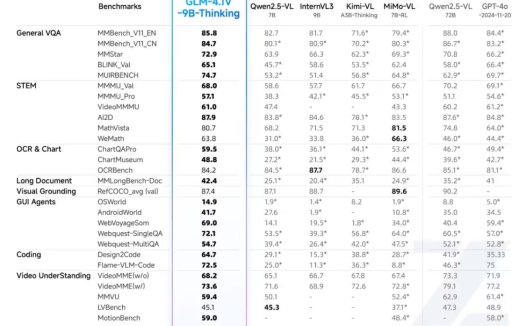

智谱开源新一代通用视觉语言模型

昨日,智谱正式推出并开源了新一代通用视觉语言模型 GLM-4.1V-Thinking,号称「GLM 系列视觉模型实现从感知走向认知的关键跃迁」。 具体来看,GLM-4.1V-Thinking 是一款支持图像、视频、文档等多模态输入的通用推理型大模型,专为复杂认知任务设计。其在 GLM-4V 架构基础上引入「思维链推理机制(CoT Reasoning)」,采用「课程采样强化学习策略(RLCS)」,系…- 779

-

智谱获浦东创投、张江集团 10 亿元战略投资,开源发布新一代通用视觉语言模型 GLM-4.1V-Thinking

7 月 2 日消息,今天上午,智谱开放平台产业生态大会在上海浦东张江科学会堂举办,开源发布新一代通用视觉语言模型 GLM-4.1V-Thinking。 在智谱开放平台产业生态大会上,智谱宣布浦东创投集团和张江集团对智谱总额 10 亿元的战略投资,并于近期完成首笔交割。同时,三方还启动了一项合作,共同建设人工智能新型基础设施。 智谱今日正式发布并开源视觉语言大模型 GLM-4.1V-Thinking…- 1.1k

-

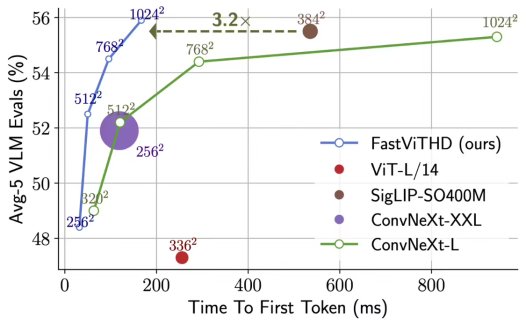

苹果发布 FastVLM 视觉语言模型,为新型智能眼镜等穿戴设备铺路

5 月 13 日消息,苹果机器学习团队上周在 GitHub 发布并开源了一款视觉语言模型 ——FastVLM,提供 0.5B、1.5B、7B 三个版本。 据介绍,该模型基于苹果自研 MLX 框架开发并借助 LLaVA 代码库进行训练,专为 Apple Silicon 设备的端侧 AI 运算进行优化。 技术文档显示,FastVLM 在保持精度的前提下,实现了高分辨率图像处理的近实时响应,同时所需的计…- 744

-

Hugging Face 最小 AI 视觉语言模型登场:2.56 亿参数,内存低于 1GB PC 也能驾驭

1 月 24 日消息,科技媒体 NeoWin 昨日(1 月 23 日)发布博文,报道称微软计划 2025 年 2 月开始,上线部署 Copilot Chat for Outlook 和 Copilot Chat for Teams,将带来全新的 Copilot 聊天体验,并提供更便捷的访问方式。 1AI援引微软更新的 Microsoft 365 路线图,附上相关信息如下: 2025 年 1 月下旬…- 1.8k

-

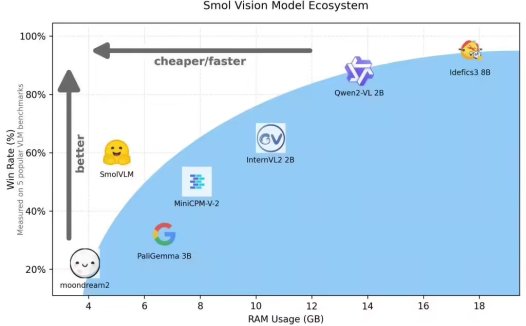

Hugging Face 发布 SmolVLM 开源 AI模型:20 亿参数,用于端侧推理,体积小、速度快

Hugging Face 平台昨日(11 月 26 日)发布博文,宣布推出 SmolVLM AI 视觉语言模型(VLM),仅有 20 亿参数,用于设备端推理,凭借其极低的内存占用在同类模型中脱颖而出。 官方表示 SmolVLM AI 模型的优点在于体积小、速度快、内存高效,并且完全开源,所有模型检查点、VLM 数据集、训练配方和工具均在 Apache 2.0 许可证下发布。 SmolVLM AI …- 5.4k

-

北大清华等联合发布 LLaVA-o1:首个自发性视觉AI模型,推理计算 Scaling 新思路

11 月 19 日消息,由北京大学、清华大学、鹏城实验室、阿里巴巴达摩院以及理海大学(Lehigh University)组成的研究团队,最新推出了 LLaVA-o1,这是首个具备自发性(Spontaneous,具体解释可参考文末)、类似于 GPT-o1 的系统性推理视觉语言模型。 LLaVA-o1 是一种新型的视觉语言模型(VLM),其设计目标是进行自主的多阶段推理。 LLaVA-o1 拥有 1…- 2.7k

❯

搜索

扫码打开当前页

返回顶部

幸运之星即将降临……

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠

-

¥優惠使用時效:无法使用使用時效:

之前

使用時效:预期有效优惠编号:×

没有优惠可用!