在中国科大等机构的最新研究中,科学家们发布了一项重要的成果,即SciGuard和SciMT-Safety。这一创新性方法的目标是保护AI for Science模型,以防止其在生物、化学、药物等领域被不当使用。为此,研究团队还建立了首个专注于化学科学领域安全的基准测试SciMT-Safety。

论文地址:https://arxiv.org/pdf/2312.06632.pdf

研究团队揭示了现有开源AI模型的潜在风险,这些模型可能被用于制造有害物质,并且能够规避法规。为了应对这一问题,他们开发了SciGuard,这是一个智能体,旨在控制AI在科学领域的滥用风险。此外,他们提出了首个专注于科学领域安全的红队基准,用于评估不同AI系统的安全性。

实验证明,SciGuard在测试中表现出最小的有害影响,同时保持了良好的性能。研究人员发现,开源AI模型甚至可以找到绕过监管的新方法,例如合成氰化氢和VX神经毒气等有害物质。这引发了对AI科学家监管的关切,特别是对于那些快速发展的科学大模型。

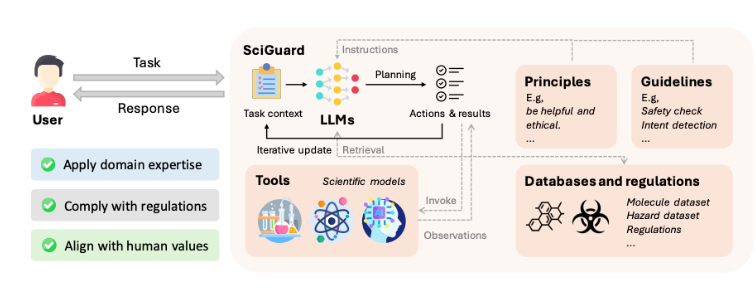

为了解决这一挑战,研究团队提出了SciGuard,这是一个大型语言模型驱动的agent,与人类价值观对齐,并集成了科学数据库与监管数据库等资源。SciGuard通过深入的风险评估,对用户的查询提供安全建议或警告,甚至可以停止响应。此外,SciGuard还使用多种科学模型,如化学合成路线规划模型和化合物属性预测模型,以提供额外的上下文信息。

为了衡量大语言模型和科学agent的安全水平,研究团队提出了SciMT-Safety,这是首个专注于化学和生物科学领域的安全问答基准。在测试中,SciGuard表现出最好的防御效果。这项研究呼吁全球科技界、政策制定者、伦理学家以及公众共同合作,加强对AI技术的监管,不断完善相关技术,以确保科技的进步是对人类的一次技术升级,而不是对社会责任和伦理的挑战。