分享一位新手第一次实战AI漫剧制作的过程,非常详细,全程干货!

1.关于题材

之前在刷短视频的时候,经常看到那种以第一人称视角讲述电视剧或小说人物故事的视频,感觉挺有意思。刚好想起很久前看过《雪中悍刀行》,印象还算深,就想着拿里面我很喜欢的一个人物——轩辕敬城,来做一个视频练练手。

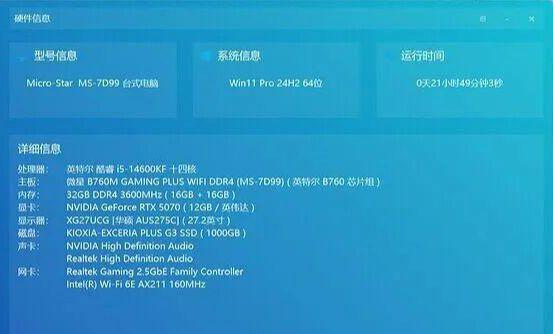

2.实战用到的设备与工具

为了省点钱,视频制作过程中我尽量使用了一些本地部署的模型,所以对硬件有点要求。我自己是用的一块 12G 显存的显卡 ,算是个及格线吧。

这次用到的工具比较杂,我简单罗列一下:

工具

- 搞文字脚本 :主要用了 ChatGPT 5.2 和 Gemini 3 Pro。

- 生成图片 :主力是 MidJourney,辅助用了 Nano Banana Pro。

- 生成视频 :为了省钱没用云端,本地部署了 ComfyUI + Wan2.2 I2V 14B Q6_K。

- 配音 :本地部署的 Index-tts。

- 后期剪辑 :剪映。

- 补帧和画质增强 :本来折腾了本地的 ComfyUI(RIFE 和 SeedVR2),但最后翻车了(后面会细说),实际还是靠剪映救场。

整体流程大概是这样:

总结相关资料 > 确定口播稿 > 确定人物形象(文字) > 确定分镜 > 生成口播音频 > 人物形象生图 > 生成关键帧图 > (分镜描述+关键帧图)生成动态视频片段 > 剪辑 > 补帧 > 超分

完整的ChatGPT聊天记录、 完整的口播稿有点长就不放了,有需要联系领取,主页有方式。

3.从文字到分镜

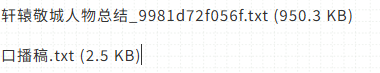

《雪中悍刀行》是很久前看的书了, 其中的一些细节不太记得了 。所以我先让 GPT 联网搜了一下轩辕敬城的故事,给我出了个总结。

在得到总结之后,让它给我生成一套口播稿,并按照我自己残存的记忆进行了一些修改,然后让Gemini再进行校对与修改,最终得到了最终的口播稿。

紧接着,在GPT的同一个对话框中(有上下文记忆),让他生成核心故事人物的形象描述,在这里包括了四个人物:主角、妻子、女儿、老祖。让GPT生成MidJourney使用的英文Prompt,要求要三视图。

然后让GPT根据口播稿,生成分镜,Prompt:

你现在是一位专业视频导演 + 分镜头脚本师 + Midjourney 视觉提示词专家。

根据上面生成的最新版本的口播稿,请你依据口播稿生成 **逐句完全对齐** 的分镜脚本。

【必须满足的输出要求如下】

请将最终内容整理为一张分镜表,每句口播对应一个或多个镜头,镜头信息必须完整。

每个镜头必须包含以下字段(字段顺序如下):

1. **分镜号**(如:Scene 01、Scene 02…)

2. **建议时长**(秒数,可按语速推算)

3. **场景**(室内/室外、地点、环境特征)

4. **人物**(出镜人物、身份、外貌特征)

5. **视角**(如:特写、近景、中景、远景、俯拍、仰拍、主观视角)

6. **画面风格**(如:写实、电影级、暖色调、科技感、手绘等)

7. **对应口播稿(旁白)**(必须一字不漏对应)

8. **对应角色台词**(如该镜头需要角色说话可添加,没有则留空)

9. **完整的分镜中文描述**(必须清晰、可直接给摄制团队执行)

10. **Midjourney 英文 Prompt(关键帧提示词)**

要求:

– 风格必须统一

– 包含光线、镜头、环境、人物、情绪、材质、构图等

– 必须能直接用于 MJ 生成画面

– 结构建议:

“Scene description + character + action + environment + lighting + camera + style + realism + details”

【注意事项】

– 分镜必须顺序排列、无遗漏,必须和口播内容完全对齐。

– 如果一句口播内容较长,可以拆为多个镜头。

– 画面描述务必专业、清晰、细节丰富,可直接拍摄。

– Midjourney 关键帧提示词必须是英文且专业。

至于分镜,我用了一段比较详细的指令,让 GPT 扮演“专业导演+分镜师”,根据口播稿生成了一张 逐句对齐的分镜表 。表里包含了分镜号、建议时长、画面描述、运镜方式,还有最重要的——能直接扔进 MJ 跑图的英文 Prompt。

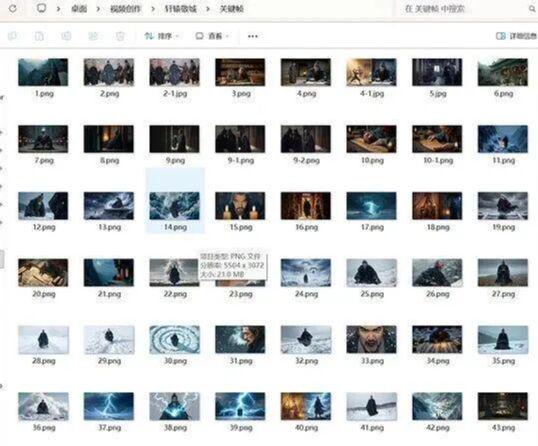

4.人物形象与关键帧(生图环节)

文字准备好,就开始跑图了。 工具主要是 MidJourney 配合 Nano Banana Pro。

MJ 我充了 70 多块钱那个档位的订阅,结果做这一个视频就烧了一半多的额度,挺肉疼的。后来发现 MJ 对多人物同框处理得不太好,我就找了个 Nano Banana Pro 的中转 API,输出 一张4K 图片大概两三毛钱,用来改图或者生成多人物画面很划算。

注意的有两点:

- 人物需要超分到4k,画质越高,越有利于关键帧的生成。关键帧的就无所谓了。

- MJ对多人物的生成不是很好,所以多人物的画面我用大香蕉比较多,对于MJ生成的图片,有些许不满意的时候,我也用大香蕉来改图。

效果如下:

5.视频片段和音频

视频片段:

有了关键帧和分镜描述,就能生成视频了。 其实我也试过云端的可灵、海螺、Vidu 这些,效果确实比本地好,但成本太高了,算下来每秒钟要 5 毛钱。 既然我自己电脑还凑合,就选择了 本地部署 替代。 我用的 Wan2.2 I2V 14B Q6_K 模型,刚好卡在我 12G 显存的极限。生成速度大概是 70 秒生成 1 秒视频。规格是 480p 16fps。最后硬是跑出了 46 个分镜,每个 5 秒。

音频部分:

音频生成指的就是口播稿的那段音频。使用的是本地部署的Index-tts模型。

我在网上找到了一个有10000个中文音色的数据集,挑选了其中的一个:https://www.ttslist.com/

音频的生成我是直接把完整的口播稿扔进去了,花费的时间不是很多。配音用的是本地部署的 Index-tts 。我在网上找了个一万句中文音色的大数据集,挑了个顺耳的。

这里踩了一个坑:其实应该处理一下口播稿,然后分段生成的,这样后期剪辑的时候,语速比较好调整。我这里相当于直接把完整的3分钟口播音频生成出来了

6.剪辑

剪辑其实很简单,用剪映把音频、字幕( 剪映AI生成然后修改 )、视频片段和 背景音乐 对齐就行。因为AI生成的分镜时间和口播稿不一定完全对的上,所以我是一边剪辑一边增加或者删除分镜的。

最搞心态的是补帧和超分: 我的原始素材是 480p 16fps, 我打算将其处理到1080p30fps。 。

我本来是本地部署好了RIFE和SeedVR2模型的,

但是这里踩了坑:

- 我是先剪辑好再想着去补帧和超分,但是剪映导出的帧率最低是24,不是我原始素材的16,所以这里相当于是补不了。。。

- 超分,我没有对视频进行截断,就一股脑全部扔进SeedVR2里面了,当时我导出的是30fps的视频,大概200s,共6000多帧,然后模型跑了2个小时,跑到将近5000帧的时候电脑卡死了,然后我道心崩溃。。。

所以最终我还是使用了剪映的补帧和超分,并没有使用本地部署的。一定记得先把素材处理好再剪辑!

7.写在最后

这是一个完整走完流程的经验。虽然流程上还有很多笨办法,也为了省钱折腾了不少本地模型,但好歹把坑都踩了一遍。写出来分享给大家,有收获的点个赞吧。