今天想和大家聊一下这个即梦推出的Seedance 2.0模型。

在我看来它做了一件很重要的事:

把传统的Ai视频制作方式的

「剧本 → 分镜 → 文生图 → 图生视频 → 剪辑」这一整套流程

直接压缩成了「故事剧本 → 出视频」,

这让视频制作的门槛降得极低,且下限抬得很高

当然,还要更高质量的视频的话,还需要一定程度的抽卡筛选镜头和剪辑技巧。

这意味着什么?我来给大家算一笔账。

先说说老流程有多”折磨人”

以前做一个60秒的YouTube Shorts视频,按照3秒一个镜头算,

至少需要20个分镜。

这20个分镜意味着什么呢?你得先想好每一个镜头的首帧画面长什么样,然后用文生图模型生成角色参考,再用角色参考图去图生图,生成20张首帧图片。接着用图生视频模型把这20张图变成20个视频片段,最后再用剪辑工具把它们拼起来,还得配音、加字幕、加转场、加背景音乐……

整个流程下来,说实话,挺折磨人的。

按照我自己用 NanobananaPro+Veo3.1 FAST模型 的制作经验来看,

平均每个镜头的首帧需要抽卡4次,每个镜头的视频需要抽卡3次以上。

一个60秒的成品视频积累下来的素材量:

首帧图大约80张,视频素材大约60个。

成本方面,云雾Api限时特价分组的图片生成价格为0.2元/张,视频生成价格为0.18元/个,

一个60秒成品视频的最低花费:

80× 0.2 + 60 × 0.18 = 26.8元

这还是保守估计。实际工作中,遇到比较复杂的镜头,可能还得调用2.7元/5s的海螺2.3模型来补抽,

一个视频的成本轻松突破30元。

Seedance 2.0带来了什么变化?

现在,我们只需要

准备一个60秒视频的剧本,生成角色参考图,

然后按照同一场景 / 同一角色 / 同一道具 / 同一服装的原则来规划一下分镜提示词。

什么意思呢?

自己在脑海中演一遍戏,每次演15s以内,然后把这15s内的剧本和用到的角色参考图交给即梦,生成视频

就可以了。

一个60秒一分钟的视频,只需要生成4次,花费360积分,

就能得到一个运镜流畅、场景连贯、角色动作自然且声画同步的连续分镜视频。

再根据第一次抽卡中不满意的地方进行第二次调整,基本就能拿到一个相当满意的成品。

从2月8日开了高级会员到今天2月10日,两天时间,我花了3800多积分,产出了5条视频,

平均单个视频消耗约760积分,折合大约21.9元/条。

不光是省钱的问题。

更关键的是,它直出的视频质量,是我怎么努力都无法通过「文生图 + 图生视频」拼接来实现的。

对我来说,这就是一个制作视频的全新利器。

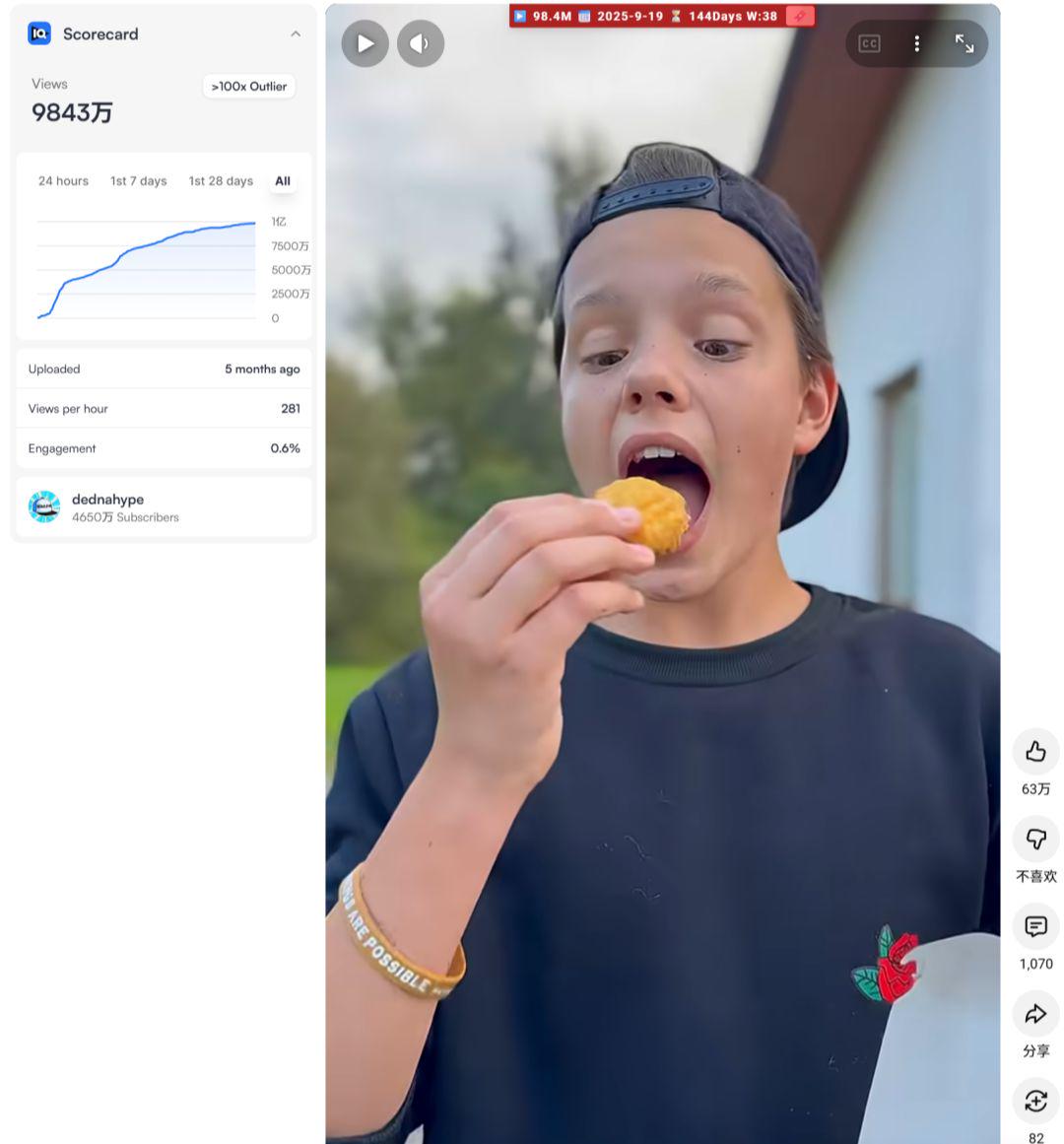

实操案例:复刻一条近亿播放的YouTube Shorts

可能大家对上面的数据还没有一个很直观的感受。

我来分享一个真人视频复刻的实操案例。

原视频链接:https://www.youtube.com/shorts/d_DCMhf9pWA

总播放量:9841万(近1亿)

视频时长:19秒

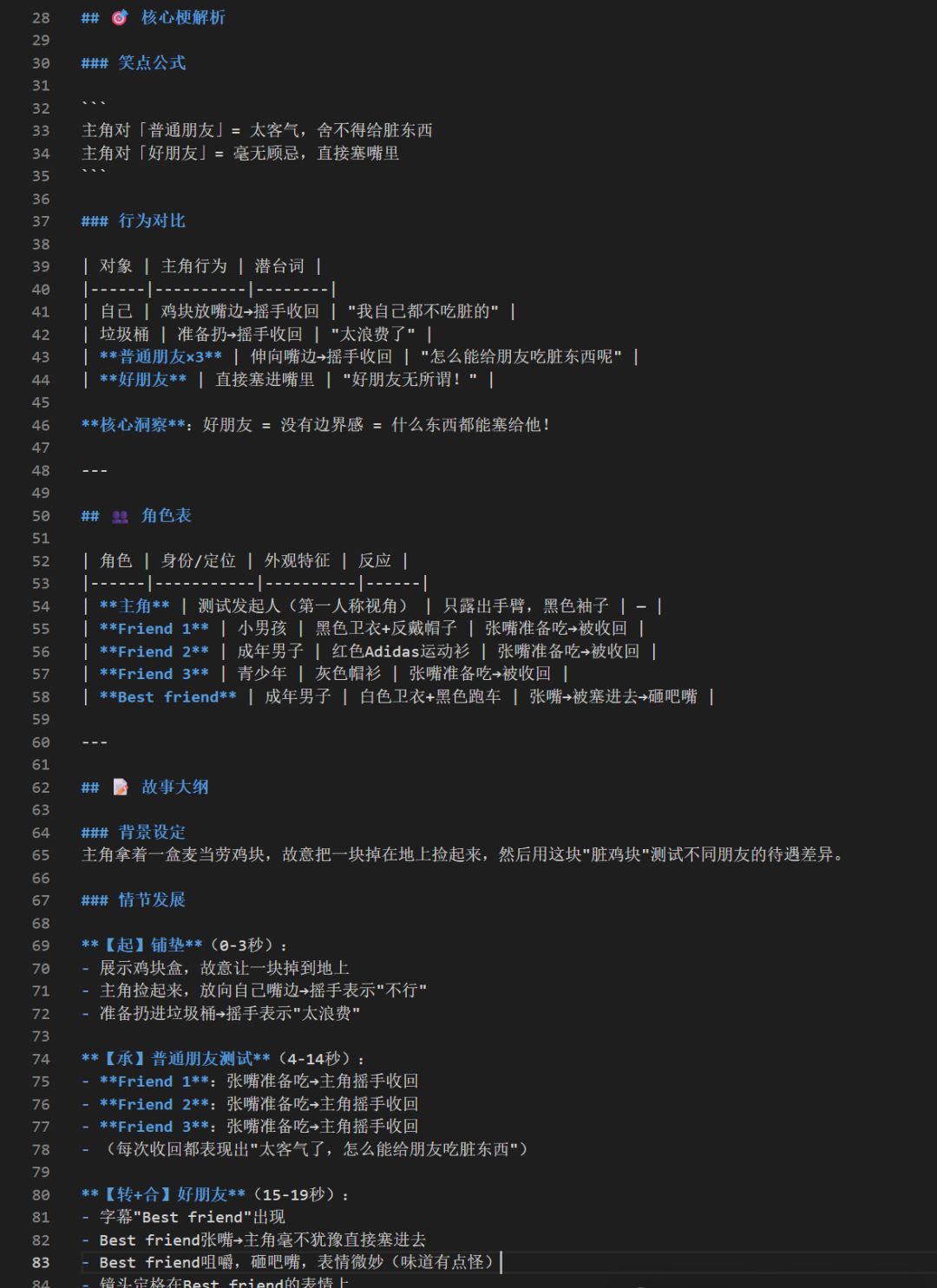

这是我对这条视频做的爆款元素拆解:

故事大纲

【起】铺垫(0-3秒):

– 展示鸡块盒,故意让一块掉到地上

– 主角捡起来,放向自己嘴边→摇手表示”不行”

– 准备扔进垃圾桶→摇手表示”太浪费”

【承】普通朋友测试(4-14秒):

– Friend 1:张嘴准备吃→主角摇手收回

– Friend 2:张嘴准备吃→主角摇手收回

– Friend 3:张嘴准备吃→主角摇手收回

– (每次收回都表现出”太客气了,怎么能给朋友吃脏东西”)

【转+合】好朋友(15-19秒):

– 字幕”Best friend”出现

– Best friend张嘴→主角毫不犹豫直接塞进去

– Best friend咀嚼,砸吧嘴,表情微妙(味道有点怪)

– 镜头定格在Best friend的表情上

分镜头拆解

#### 场景1:开场 + 鸡块掉地(0-2秒)

| 镜号 | 景别 | 画面描述 | 动作 |

|——|——|———-|——|

| 1 | 特写 | 手持白色纸盒,内有鸡块 | 一块鸡块掉落 |

| 2 | 俯拍 | 鸡块落在灰色砖地上 | 手伸下去捡起来 |

#### 场景2:自我测试(2-3秒)

| 镜号 | 景别 | 画面描述 | 动作 |

|——|——|———-|——|

| 3 | 特写 | 脏鸡块放向自己嘴边 | 摇手→收回 |

| 4 | 中景 | 鸡块伸向垃圾桶 | 摇手→收回 |

#### 场景3:Friend 1 测试(4-6秒)

| 镜号 | 景别 | 画面描述 | 动作 |

|——|——|———-|——|

| 5 | 中景 | 小男孩看到鸡块 | 张大嘴巴准备吃 |

| 6 | 特写 | 鸡块伸到嘴边 | 主角摇手→收回 |

**字幕**:FRIEND

#### 场景4:Friend 2 测试(7-9秒)

| 镜号 | 景别 | 画面描述 | 动作 |

|——|——|———-|——|

| 7 | 中景 | 红衣男子坐在车内 | 张嘴准备吃 |

| 8 | 特写 | 鸡块伸到嘴边 | 主角摇手→收回 |

**字幕**:FRIEND

#### 场景5:Friend 3 测试(10-13秒)

| 镜号 | 景别 | 画面描述 | 动作 |

|——|——|———-|——|

| 9 | 中景 | 灰衣青少年 | 张嘴准备吃 |

| 10 | 特写 | 鸡块伸到嘴边 | 主角摇手→收回 |

**字幕**:FRIEND

#### 场景6:Best friend 测试(14-19秒)⚡核心笑点

| 镜号 | 景别 | 画面描述 | 动作 |

|——|——|———-|——|

| 11 | 中景 | 白衣男子站在黑色跑车旁 | 张嘴准备吃 |

| 12 | 特写 | 鸡块伸向嘴边 | **直接塞进去**(无犹豫) |

| 13 | 特写 | Best friend面部表情 | 咀嚼,砸吧嘴,微妙表情 |

**字幕**:Best friend

好的,上面是原视频的故事大纲与分镜头拆解

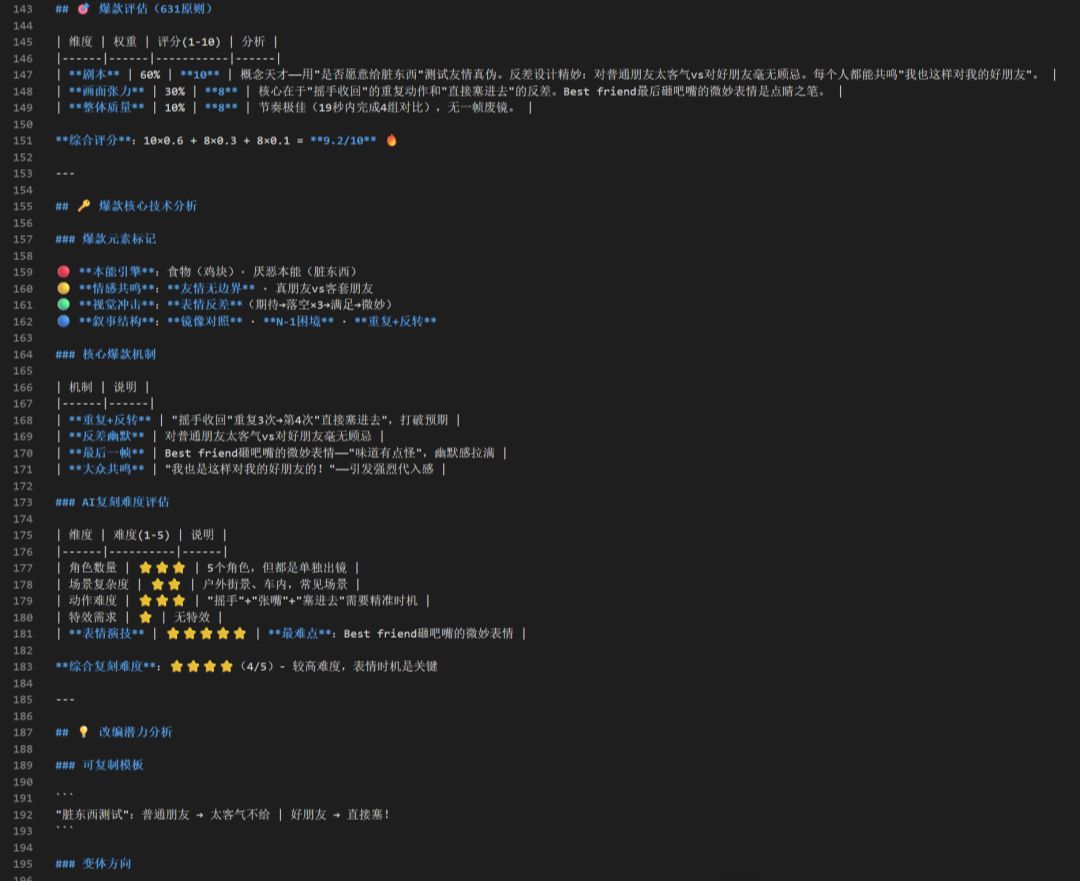

下面,为了避免同质化,我决定把鸡块换成蛋糕,把角色换成Kpop猎魔女团的角色来获取流量。

那我们来试试用老流程

【文生图+图生视频——结合Kpop猎魔女团的IP】来复刻这种视频,

看看我之前的提示词要怎么写:

### 镜头1:蛋糕掉落

**Characters**: [Rumi]

**Analysis**: 建立”脏蛋糕”这个测试道具。

**Image Prompt (T2I)**:

“`

第一人称视角。户外草地派对场景,彩色气球装饰。

[Rumi]双手捧着一块三角形生日蛋糕(白色奶油+草莓),

蛋糕刚刚开始从手中滑落。蛋糕下方是绿色草地。

特写镜头对焦在蛋糕上。动态模糊感。竖版9:16。电影色调。

“`

**Video Prompt (I2V)**:

“`

第一人称视角。蛋糕从手中完全滑落,慢动作掉落到草地上,奶油溅开沾上草屑。

一只女性的手伸下去,把蛋糕捡起来。蛋糕表面沾了明显的绿色草屑和泥土。

(无台词)

“`

—

### 镜头2:自我犹豫

**Lens ID**: Lens_2

**Characters**: [Rumi]

**Analysis**: 用摇手动作铺垫”这东西脏了不能吃”的规则。

**Image Prompt (T2I)**:

“`

Rumi拿着沾满草屑的生日蛋糕,放在自己嘴边。蛋糕表面有明显的绿色草屑。

背景虚化是户外草地。竖版9:16。

“`

**Video Prompt (I2V)**:

“`

Rumi手把蛋糕凑近自己嘴边停顿0.5秒,

然后另一只手腕左右摆动(摇手)表示”不行”。

满脸嫌弃地说:”I’m not going to eat the cake on the ground!”

“`

……

好,我们先看看上面这两个镜头

因为写到这里,我已经不想再往下写了😂。

我非常清楚,我常用的Veo3.1模型根本搞不定这样的任务。

第一个坑:

为了保持蛋糕的视觉一致性,我得先生成一个原始三角形生日蛋糕的参考图用在镜头1里,

输入:”一个三角形的生日蛋糕(白色奶油 + 草莓),背景为纯白色。” 得到的图

首先这个蛋糕我就非常不满意,提示词得改几遍,还得抽几次卡。

然后再从生成好的镜头1视频中,把「沾了草屑的蛋糕」单独提取出来,放进镜头2的文生图里做参考。光这一步就已经很折腾了。

而我想要的蛋糕效果长这样:

相信我,原来你可能连【生成蛋糕参考图】的这一步都得去先去网上找一个相似的来给NanoBanana图生图😂。

第二个坑:根据我的经验,Veo3.1模型抽十次卡也抽不出这个镜头:

手把蛋糕凑近自己嘴边停顿0.5秒,然后手腕左右摆动(摇手)表示”不行”,

并说:”I’m not going to eat the cake on the ground!”

之前觉得很强的Veo3.1, 现在来看真是太一般了……

来看看即梦Seedance 2.0是怎么做的

那么来到即梦,我是怎么做的呢?

这条视频前15秒视频的提示词是什么呢?就是下面这些:

户外草地派对场景,彩色气球装饰,阳光明媚。 特写镜头。

中景,Rumi 双手捧着一块三角形生日蛋糕(白色奶油加草莓),蛋糕突然从手中滑落,掉落到草地上,奶油溅开沾上草屑。

特写,Rumi 蹲下把蛋糕捡起来,蛋糕表面沾了明显的绿色草屑。

近景,Rumi 的手把沾满草屑的蛋糕凑向自己嘴边,停顿片刻,想了想表示不行,说:”I’m not going to eat the cake on the ground!”。

切换到Rumi的第一视角镜头,中景,她的手又把蛋糕移向旁边的垃圾桶准备扔掉,再次摇手表示:”This is too wasteful,No!”。

中景。Mira 坐在白色折叠椅上。Rumi 把蛋糕递到 Mira 面前。Mira看到蛋糕眼睛发亮,立刻张大嘴巴仰头,表情期待像小鸟等喂食。Rumi 的手停在 Mira 嘴边片刻,然后开始摇手,Rumi同时说 “No no no, can’t give you this.”,蛋糕被收回。Mira 保持张嘴姿势愣了一下,然后表情变成困惑不解。

场景切换到派对帐篷旁。中景,Abby 站着看到蛋糕后张嘴准备吃。Rumi 的手又停在嘴边,开始摇手说 “Nope, too dirty for you.”,收回蛋糕。Abby 保持张嘴姿势愣住,然后嘴巴缓慢合上表情茫然。

场景切换到野餐毯上。Zoe 笑着配合张嘴,迎接Rumi伸过来的蛋糕,以为能吃到。Rumi 的手停在嘴边又开始摇手,Rumi说 “Sorry bestie, I can’t.”,再次收回。Zoe 先愣住然后双手向两边摊开,表情无语耸肩做出你搞什么的表情。

……

我只给了即梦角色参考图和上面这份分镜剧本,就直接出了成片

(猫和老鼠音效是我后期加的)。

整个过程中最长的等待时间是排队生成视频的时间,

而这个时间我正好可以去写下一条视频的分镜剧本,完全不浪费。

完成这条成片,我总共抽了几次卡?

4次,360积分,总成本大约10.5元。

按照语言类0.1的RPM来看,我只需要不到2万的互动播放就能覆盖成本。

而实际数据呢?

从2月8日到2月10日,我用即梦产出的视频播放量加起来已经破百万了,数据曲线还在往上走,Roi极高。

写在最后,一些注意事项和建议

现在唯一的问题:

生成速度太慢了

前两天还好,特别是今天2月10号,随着这个模型火爆全网,

即使我开了高级会员,出一个15秒的视频也需要排队差不多40多分钟,

目前没有API可以调用,等得确实着急😂。

另外,不少圈友提到即梦新增了真人人脸的限制。

经过我的测试,发现可以通过生成人物三视图来规避

——当你上传单独的一张真人照片,特别是面部特写时,

它会提示

「识别到你上传的素材中包含人脸信息,请调整素材后再试试」。

但如果你上传的是三视图的参考,就不会触发这个限制。

为什么说现在是最好的入局窗口期?

其实回过头来看,目前这个模型还处于灰度测试阶段,网上大部分人都只是凑个热闹。

现在的服务器也承载不了专业工作室的高强度使用,更别提国外用户了,他们甚至都还用不了这个模型

这正是我们做油管的圈友独占的好时机。

海外的观众还没见识过如此流畅的AI视频,这是一个弯道超车的绝佳机会。

所有过去的爆款,特别是真人视频,都可以趁这个窗口期复刻一遍。

之前真人视频难复刻的主要原因在于「表演」。

经过我的测试,现在通过Seedance 2.0生成的视频,

演技甚至已经超越真人了。

建议所有在做油管的圈友,尽快去尝试使用,重点提升自己写分镜剧本的能力。

越快越好。