昨天,由多位 OpenAI 前高管创立的 Thinking Machines Lab(TML),终于在成立半年后,发布了其首篇重磅研究论文《Defeating Nondeterminism in LLM Inference》(克服 LLM 推理中的不确定性)。

据 TML 介绍,未来将频繁发布博客文章、开源代码以及各种研究成果,既是「造福公众」,也是为了「优化我们自己的研究文化」。而其首篇论文则作为全新博客系列《Connectionism》的开山之作。

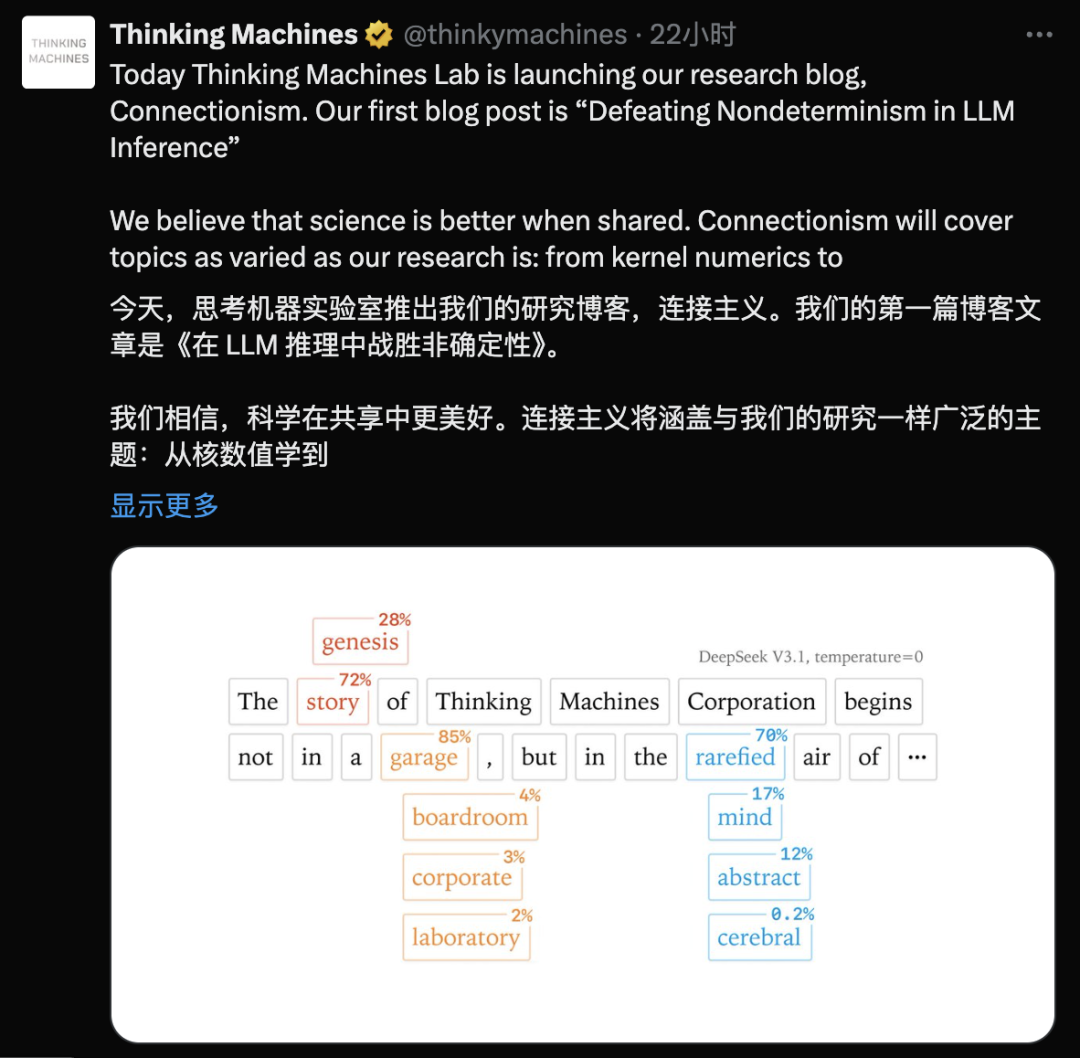

此前,大家经常能看到 ChatGPT 等 AI 每次给出的答案都不太一样,而这一现象早就被视作习以为常——大家都认为现在的 AI 模型就是概率模型。而 TML 则试图通过本次成果来解决这个老大难。

在论文内容方面,TML 认为 AI 模型产生随机性的罪魁祸首,其实是 GPU 内核 —— 就是那些在英伟达芯片里跑的小程序 —— 在推理过程中的拼接方式有问题。

文章的核心作者是 Thinking Machines Lab 的 AI 研究员 Horace He,他的解决思路很巧妙,如果能精确控制这一层的执行流程,就有可能让 AI 模型的输出变得更加稳定可靠。

此外,除了提供更靠谱的 AI 响应,让 AI 模型生成可重复的答案还有个更大的价值——能显著改善强化学习(RL)训练效果。Horace He 认为,更一致的响应能让整个 RL 训练过程「丝滑」很多。

据了解,Mira Murati 是 OpenAI 的前 CTO,同时目前也是 Thinking Machines Lab 的创始人兼 CEO。她在 7 月份就曾表示 Thinking Machines Lab 已经完成 20 亿美元的融资,且首款产品将在未来几个月内亮相,并且会对研究人员和正在开发定制模型的初创公司大有裨益。

而据最新消息显示,TML 在「0 产品 0 用户」的情况下,估值已经狂飙 120 亿美元(折合人民币 850 亿元)。