今天凌晨,阿里通义发布了下一代基础模型架构 Qwen3-Next,并开源了基于该架构的 Qwen3-Next-80B-A3B 系列模型。

官方表示,其认为 Context Length Scaling 和 Total Parameter Scaling 是未来大模型发展的两大趋势。为了进一步提升模型在长上下文和大规模总参数下的训练和推理效率,通义千问设计了全新的 Qwen3-Next 的模型结构。

据介绍,Qwen3-Next 相比 Qwen3 的 MoE 模型结构,进行了以下核心改进:混合注意力机制、高稀疏度 MoE 结构、一系列训练稳定友好的优化,以及提升推理效率的多 token 预测机制。

基于 Qwen3-Next 的模型结构,通义还训练了 Qwen3-Next-80B-A3B-Base 模型。该模型拥有 800 亿参数仅激活 30 亿参数,并实现了与Qwen3-32B dense 模型相近甚至略好的性能。

而 Qwen3-Next-80B-A3B-Base 训练成本(GPU hours)仅为 Qwen3-32B 的十分之一不到,在 32k 以上的上下文下的推理吞吐则是 Qwen3-32B 的十倍以上,实现了极致的训练和推理性价比。

同时,通义还基于 Qwen3-Next-80B-A3B-Base 型, 同步开发并发布了 Qwen3-Next-80B-A3B-Instruct 与 Qwen3-Next-80B-A3B-Thinking:

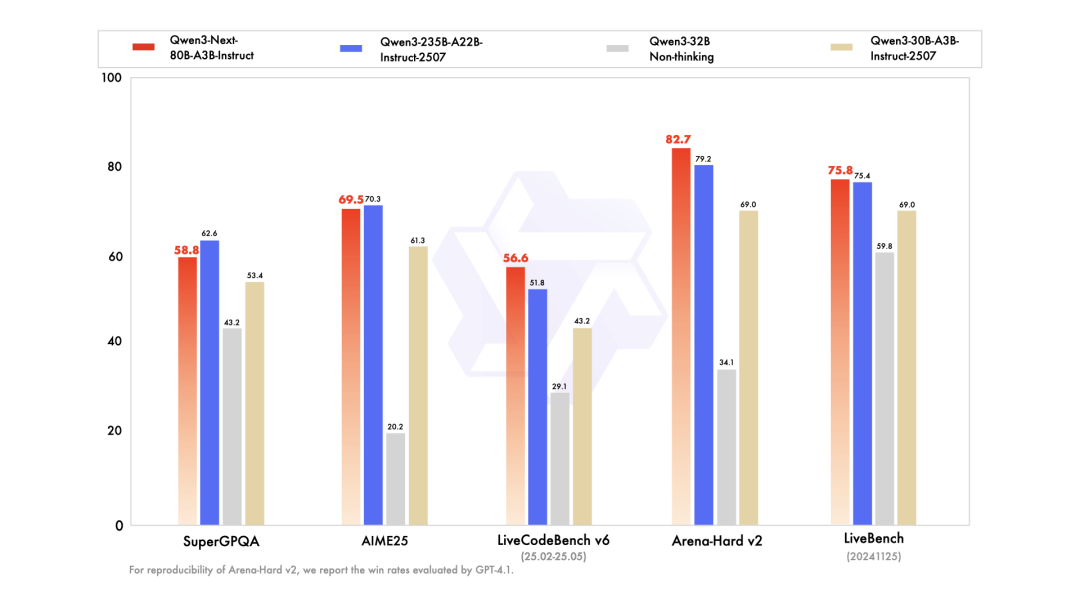

Qwen3-Next-80B-A3B-Instruct 与旗舰模型 Qwen3-235B-A22B-Instruct-2507 表现相当,同时在 256K 超长上下文处理任务中展现出显著优势;

Qwen3-Next-80B-A3B-Thinking 在复杂推理任务上表现卓越,不仅优于预训练成本更高的 Qwen3-30B-A3B-Thinking-2507 与 Qwen3-32B-Thinking,更在多项基准测试中超越闭源模型 Gemini-2.5-Flash-Thinking,部分关键指标已逼近 Qwen3-235B-A22B-Thinking-2507。

目前,新模型已上线。

免费体验:https://chat.qwen.ai/

魔搭:https://modelscope.cn/collections/Qwen3-Next-c314f23bd0264a

HuggingFace:https://huggingface.co/collections/Qwen/qwen3-next-68c25fd6838e585db8eeea9d

阿里云百炼:https://help.aliyun.com/zh/model-studio/models#2c9c4628c9yyd