通义万相又开源了全新动作生成模型通义万相Wan2.2-Animate,该模型同时支持动作模仿和角色扮演两种模式,今天就有大神放出了它的工作流,我们一起来看下如何在本地使用它。

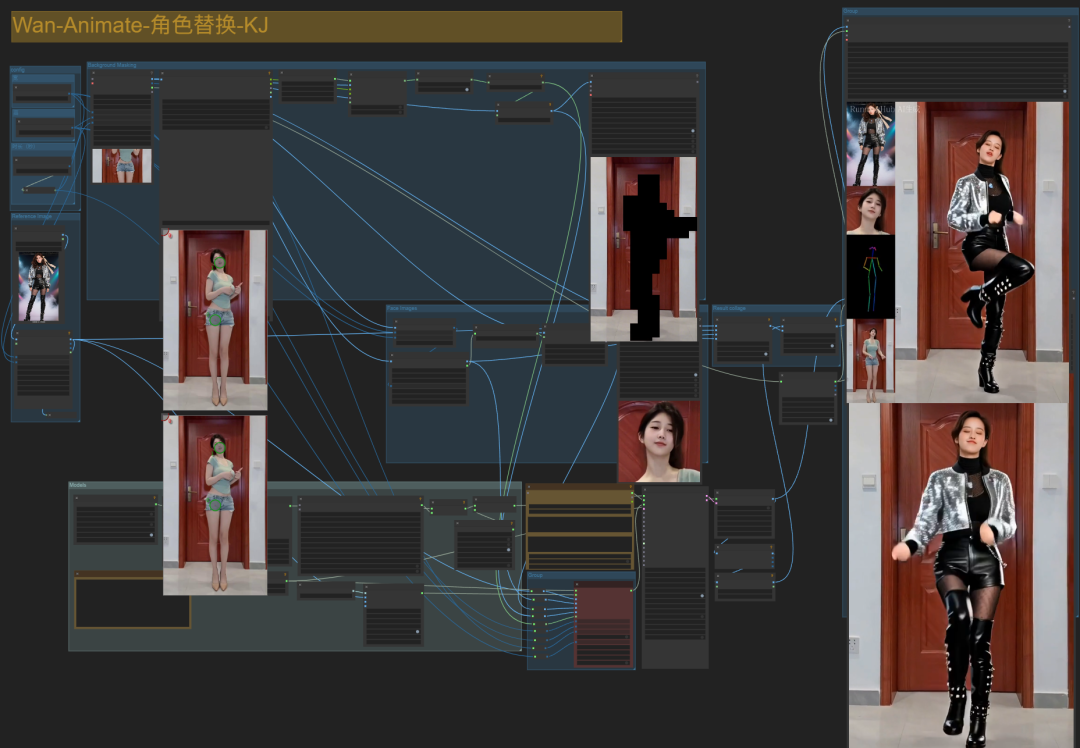

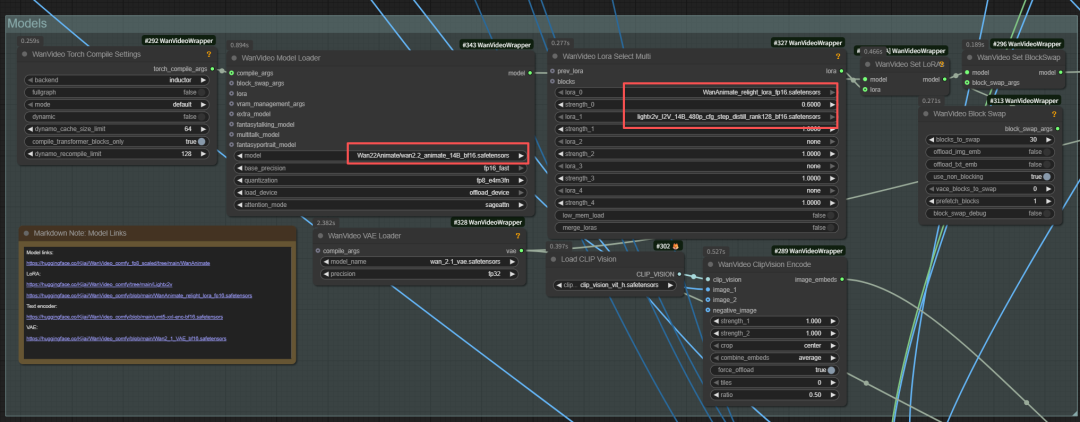

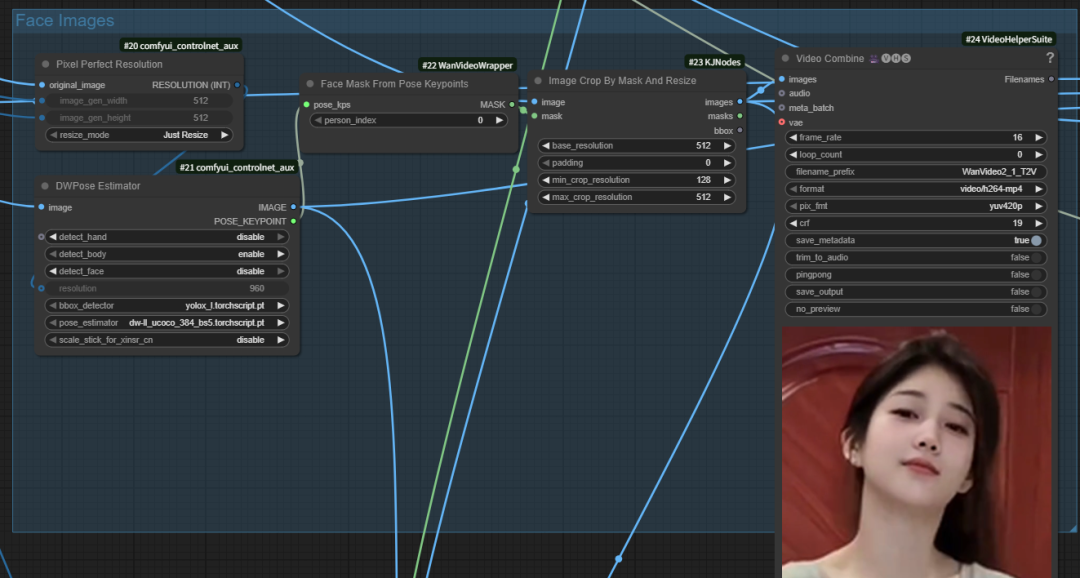

先来看下完整的工作流:

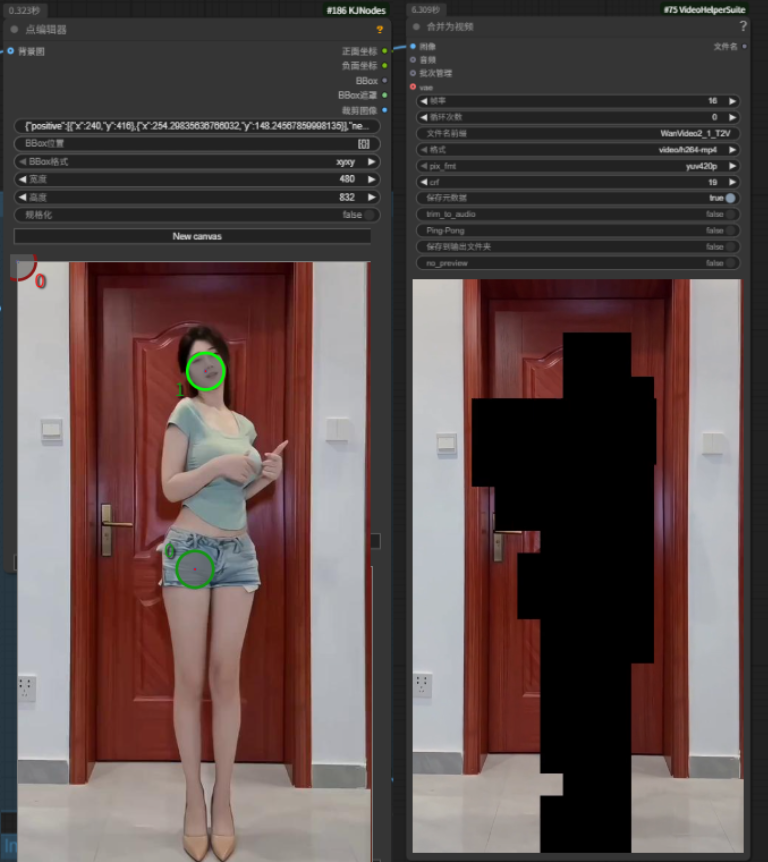

首先,我们要先将comfyUI和KJnodes都更新到最新版本,这里要用到它最新的动态的遮罩功能。

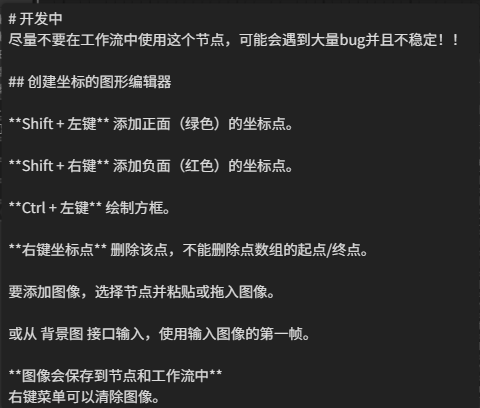

关于这个遮罩的使用方法,将鼠标放在节点上会有提示。

简单来说,红色是排除区域,绿色是保留区域。如果遮罩区域不准确的话,可以手动按shift+鼠标左键增加识别点,也可以对识别点进行拖动。

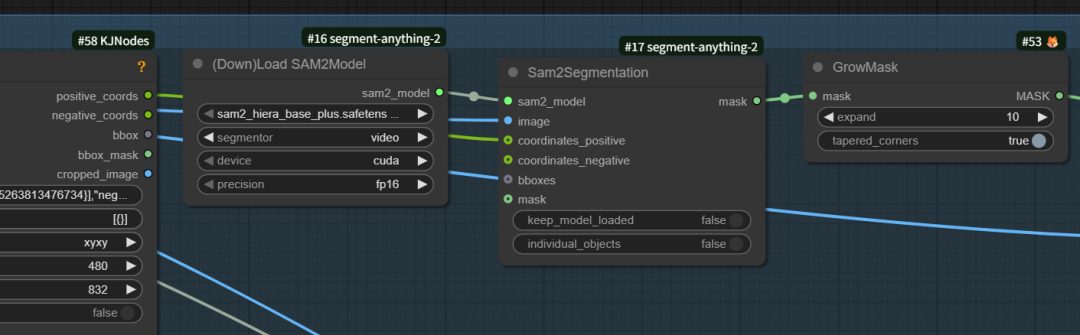

KJnodes再通过Sam2分割节点,将刚刚识别的要的和不要的部分区分开来,也就是视频中的背景部分和要替换的人物部分,其中人物部分变成了矩形的马赛克。

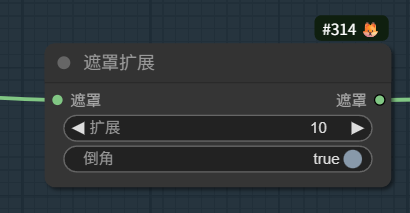

为了防止遮罩区域不准确,在遮罩后还做了一个遮罩扩展,默认扩展10个像素,如果生成的人物视频不准确,试着更改这个扩展值。

参考图片节点后面连接了一个尺寸重置节点。

上传的参考图片和参考视频的宽高比例尽量一致,不然图片会被拉伸,生成的视频中人物比例会比较怪异。

下面这张就是上传参考图片比例不一致,拉伸变形后的效果。

模型区

这里主要讲的就是加载了WanWan22Animate模型以及wananimate重新打光lora和lightx2v加速lora,如果你想速度更快一些,可以将模型换成FP8的,其他没什么特别注意的地方。

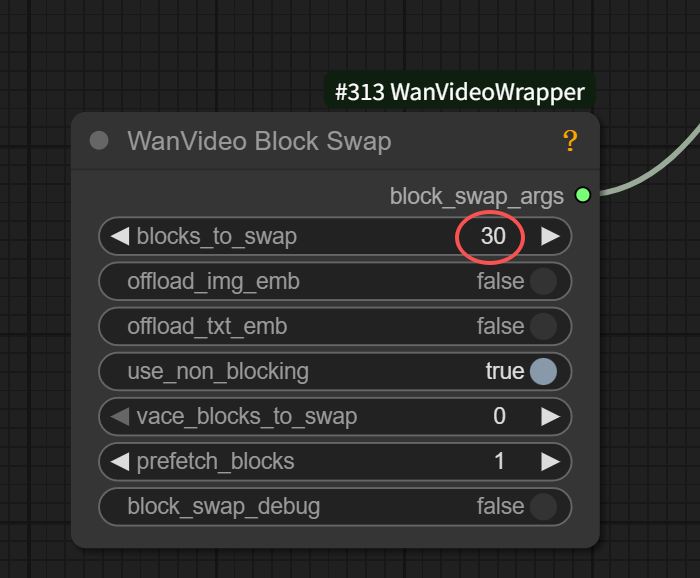

块交换这里如果设为40,跑720P的视频,大概需要24G显存不到,如果480P的视频,显存大概在15G左右。

所以如果你显存小,可以降低视频分辨率。

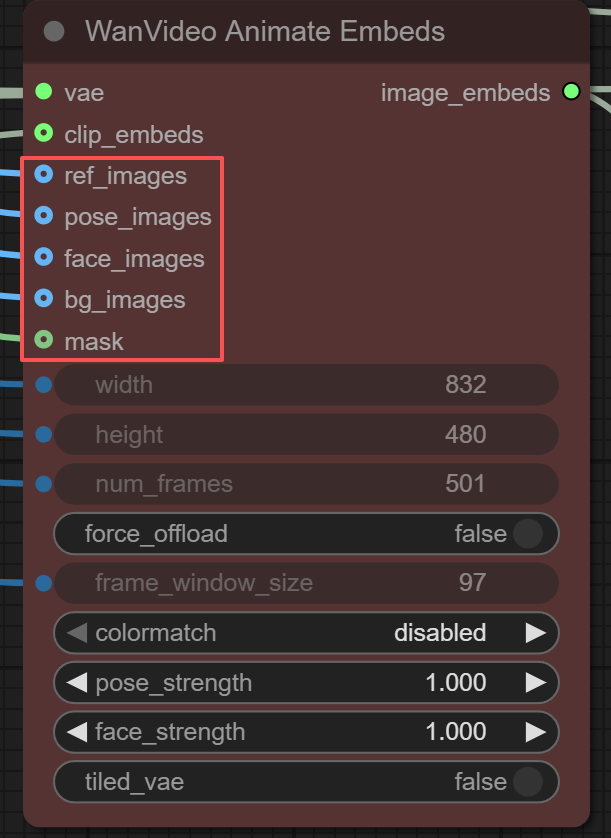

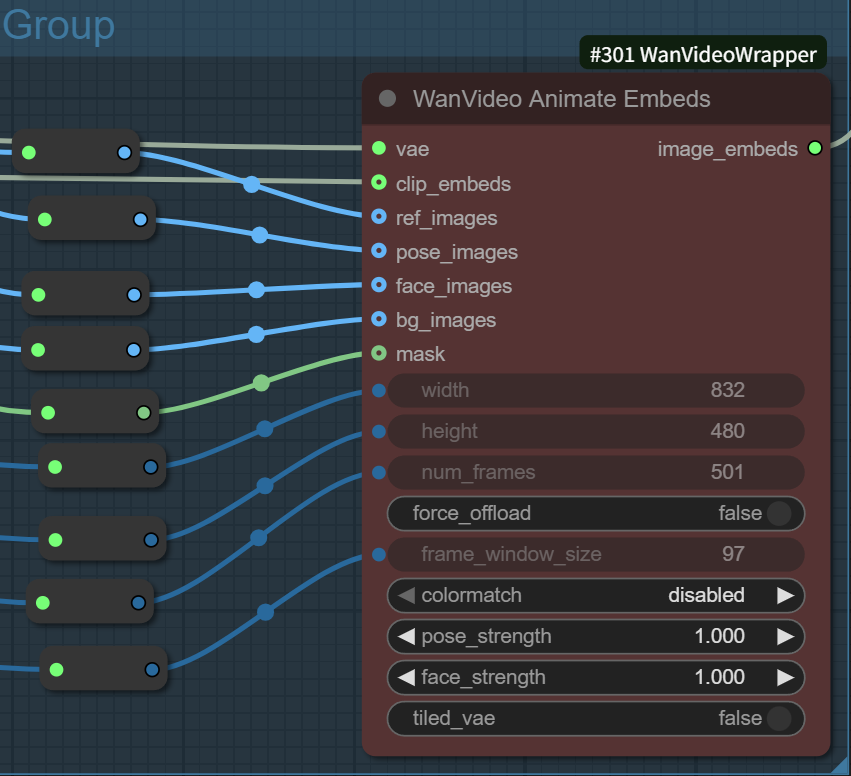

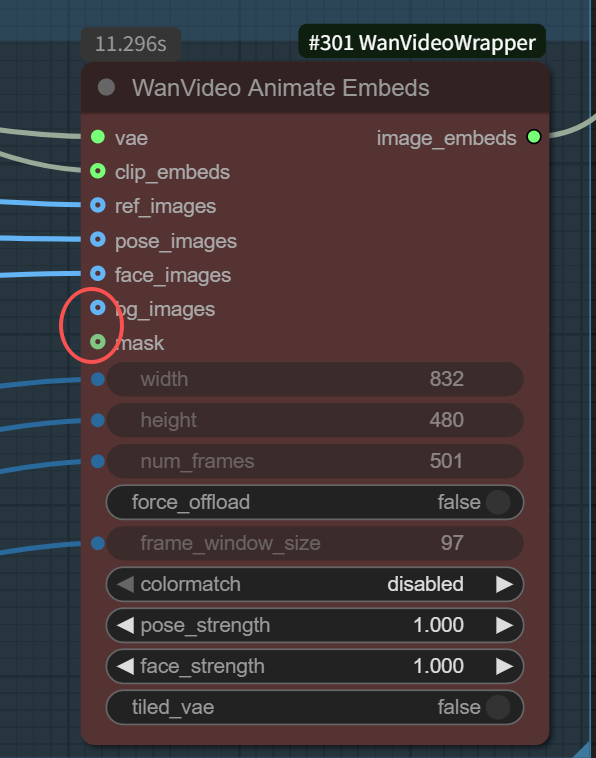

整个工作流中最重要的节点就是WanVideoAnimateEmbeds节点了。

从这节点中可以看出来,它除了连接了VAE、CLIP视频编码器外,还连接了我们上传的参考图片,以及由我们上传的参考视频得来的人物姿势图像、人物面部图像、背景图像和上面提到的遮罩图像。

从另一个方面来说,这些连接点是可以独立出来的,我们可以选择全部连接它们或只连接部分来实现不同的效果。

还有一种玩法,就是我们单独连接一个面部参考、姿势参考或背景参考来实现不同的功能。

面部图片区域是用来捕捉参考视频中的人物表情变化的。

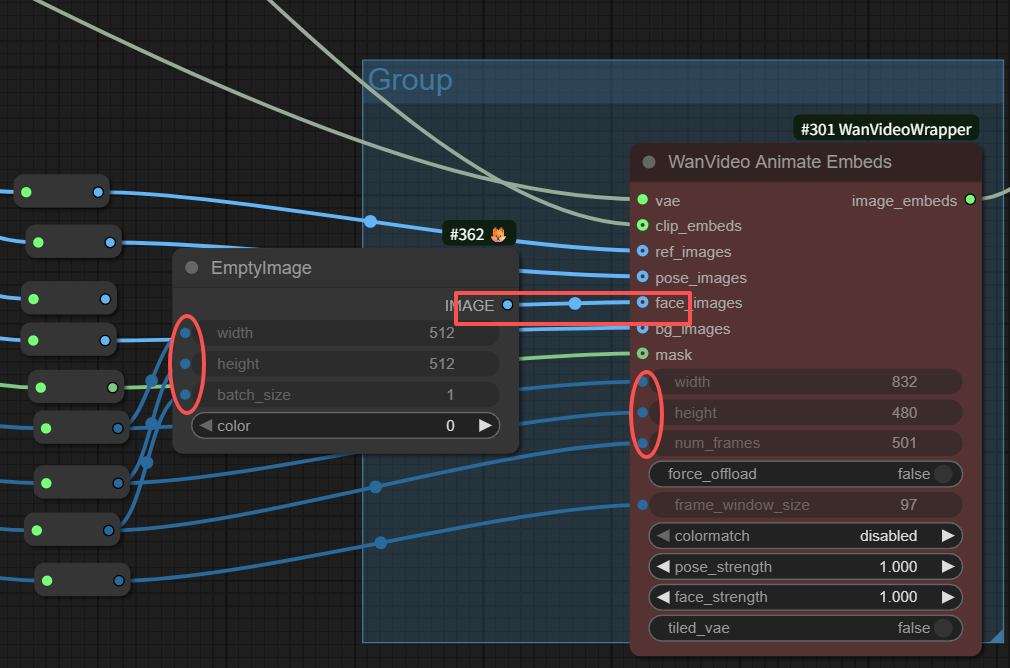

非人类如何进行脸部参考

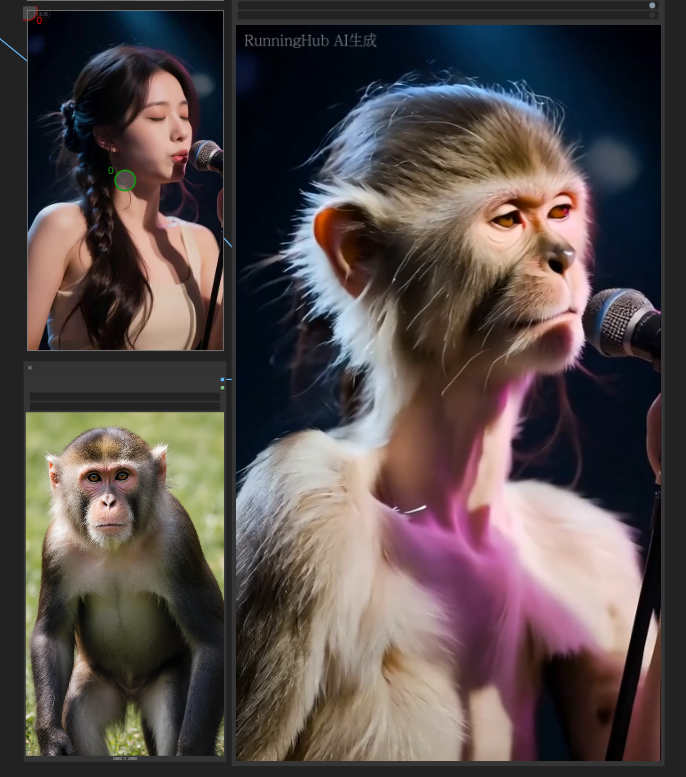

如果我们用一张非人类图片去生成视频,比如下面用一张猴子图片和一个女人唱歌的视频作为参考,也能生成猴子唱歌的视频。

但猴子的嘴是人的嘴,比较怪异。

那么如何保持猴子的脸部特征呢?

我们可以对原工作流进行一些修改,用空图像连接脸部图像(记住别忘记连接一下图像的宽高尺寸和总帧数)。

这样生成的视频就不会参考原视频的脸部,只用我们的参考图片的脸部来生成视频。

这样我们就生成了一只猴子的唱歌视频,脸部完全参考猴子的,姿势参考原视频的。

角色替换工作流实例:

只要WanVideoAnimateEmbeds节点全部正常连接,生成的视频就是角色替换工作流。

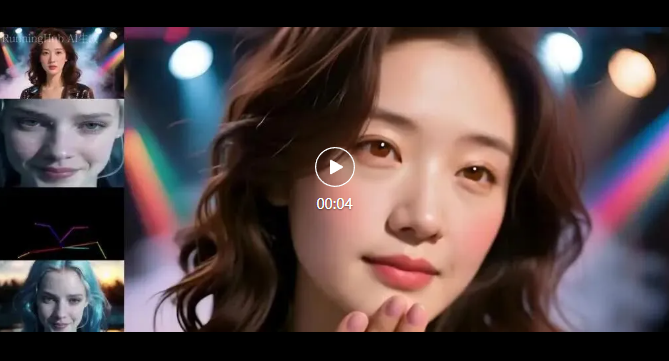

下面这个是默认工作流跑出来的视频,人物表情、动作的复现都比较完美。

动作参考视频工作流实例:

把背景和遮罩连接处断开就是动作动作参考视频工作流。

这两处断开后,生成的视频将不再从参考视频中获取背景图片和遮罩,将采样参考图片的背景来生成视频。

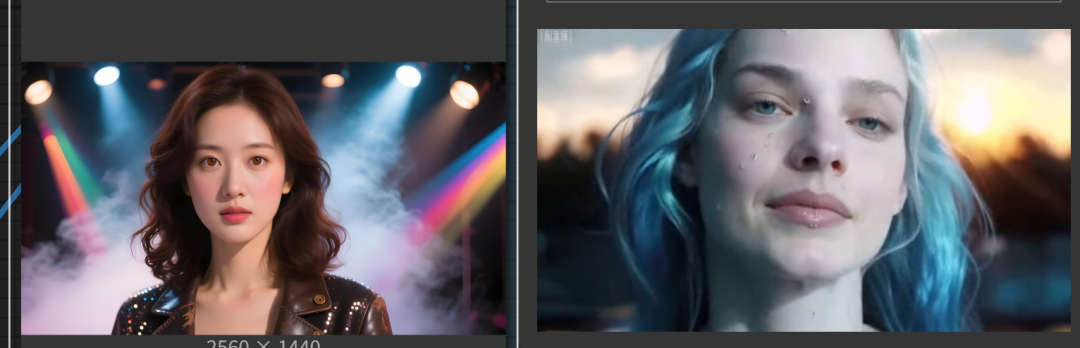

下图中上面的左图是参考图片,右面的是参考视频,生成的视频只参考了参考视频的动作,背景还是用的参考图片里的背景。

视频如下:

下面是模型的下载地址和项目页地址:

模型抱脸下载地址:

relighting-lora:

https://huggingface.co/Kijai/WanVideo_comfy/blob/main/WanAnimate_relight_lora_fp16.safetensors

Kijai版主模型:

https://huggingface.co/Kijai/WanVideo_comfy_fp8_scaled/tree/main/Wan22Animate

Kijai版gguf模型:

https://huggingface.co/Kijai/WanVideo_comfy_GGUF/tree/main/Wan22Animate

comfyui官方模型下载地址:

https://huggingface.co/Comfy-Org/Wan_2.2_ComfyUI_Repackaged/blob/main/split_files/diffusion_models/wan2.2_animate_14B_bf16.safetensors

KJnodes地址:

https://github.com/kijai/ComfyUI-KJNodes

Kj wanvideo warpper地址:

https://github.com/kijai/ComfyUI-WanVideoWrapper