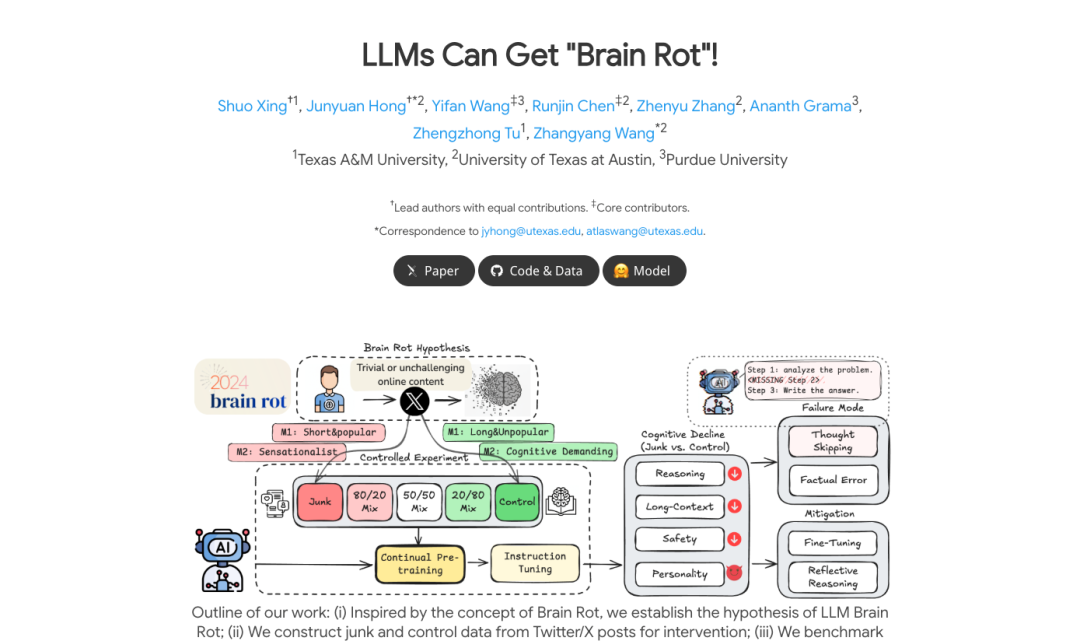

10 月 22 日消息,近日,在多所高校联合发布的题为《大语言模型可能会得「脑腐化」!》的论文中,研究团队指出,大型语言模型在持续接触低质量网络社交平台文本后,会出现类似人类「认知退化」的现象。

研究人员通过从 X 平台构建「垃圾数据」与「对照数据」,并对多种模型进行持续预训练实验。

结果显示,当模型暴露于高比例「垃圾数据」时,其在推理、长文本理解、安全性以及人格倾向等方面均出现显著下降。

错误分析显示,模型的主要问题是「思维跳跃」:越来越倾向于截断或跳过解决问题所需的关键推理链条。

研究者进一步比较了不同类型的社交媒体帖子,发现「参与度」是最强的毒性指标 —— 越容易病毒式传播的内容,越容易导致模型认知退化。

更令人担忧的是,这种衰退具有持久性。即便在后续阶段补充高质量数据进行指令微调或继续预训练,模型也只能部分恢复,仍存在表征漂移。

研究团队指出,这一现象与人类在长期接触碎片化、低营养信息时的「脑腐化」类似,强调了数据质量在大模型持续训练中的关键作用。研究团队呼吁业界将「认知健康检查」纳入模型维护流程,以避免能力长期退化。

🔗 研究项目:https://llm-brain-rot.github.io/