最近 AI漫剧确实很火。但真正能拿来学习、复刻的完整流程,其实并不多。

很多人想入局,却卡在同一个问题:不知道 AI漫剧到底该怎么做,怎么从0 跑通一条可落地的制作流程。

前段时间,我们整理了一套真实商业漫剧案例,原本只用于公司内部培训。资料本身很有价值,流程是实打实跑过的。

这次拿出来分享,也很简单——希望能帮到正在摸索方向的人,也借这个机会,认识更多认真做漫剧、愿意交流甚至合作的朋友。

此次案例会用到几乎市面上AI视频创作的主流工具。虽说如今市面上已出现众多一键成片的 Agent 工具,能大幅提升效率,但要是想打造精品,多数情况下仍需遵循传统 “分镜 – 视频 – 剪辑” 的制作流程,也就是我们多次提到的 “文 – 图 – 视 – 音 – 剪” 工作流程。

从基础技能角度考量,我们希望大家具备传统的分镜意识、出图改图能力、基本的提示词撰写能力以及剪辑能力,同时不断积累传统影视相关的视听语言逻辑与审美能力。

如此一来,未来无论面对何种应用场景,都能从容应对。

一、剧本和分镜脚本

当我们聊完选题,真正进入商业项目的实战制作时,你会发现一个很现实的情况:

绝大多数时候,我们其实是跳过了“创作剧本”这个环节的。客户或者项目方给到我们手里的,往往已经是一个现成的小说片段、一个写好的剧本,甚至直接就是一份分镜脚本。

所以,作为 AI 视频创作者,在这一阶段我们要做的工作,本质上不是“写作”,而是“翻译”与“重构”。我们需要把文字语言,翻译成 AI 能够理解的镜头语言。

面对客户给到的不同素材,我们的处理方式通常分为两种情况。

第一种情况:拿到的是现成的分镜脚本

如果你的甲方非常专业,直接甩过来一个把分镜拆得非常完备的表格,里面涵盖了景别、构图、画面内容等等,这当然是好事。但请记住,这时候千万不要直接打开 AI 工具开始跑图。

拿到分镜后的第一件事,是沟通。虽然我们不需要重新写剧本,但必须通过沟通去对齐认知。你得充分理解整个片子的故事梗概以及世界观。

是赛博朋克的霓虹感?还是东方玄幻的留白?只有搞懂了这些,你才能把握住角色的人设和美术风格。

这一点至关重要,否则你跑出来的画面哪怕构图再对,味道也是错的。

尽管接到的需求是制作预告片,但手头的分镜脚本却包含五幕内容,每一幕各自为一场短戏,各场戏之间关联性较弱,并且涉及十个不同的角色形象。这无疑对我们在整体节奏把控、画面呈现以及最终剪辑水平等方面,提出了较高的要求。

于是我们第一时间与编剧老师进行沟通,了解里面的世界观和人设。很多时候光看剧本以及分镜脚本是看不出这些东西的。这就是为什么,传统影视行业的编剧在将小说改编成剧本的时候要先通读一遍原著小说的原因。

最后,你需要像导演审视剧本一样,在脑海里把这些分镜预演一遍。如果发现某些画面在 AI 现有的技术条件下很难实现(比如极度复杂的多人交互长镜头),就要在制作前就提出来,给出替代方案。

第二种情况:拿到的是剧本

这是更常见的状态。我们要做的,就是按照视听逻辑,把它拆解成一份标准的分镜脚本表格。

这个分镜脚本表格的表头通常包括:分镜号、景别、镜头运动、画面内容、音效/台词、时长。

当然,我们可以利用大语言模型来帮我们完成从“文本”到“表格”的初版转化。你可以使用下面这段提示词,让 AI 帮你完成粗剪:

🎨

【提示词模板:文本转初版分镜】

Role: 专业的商业短片分镜师

Task: 请阅读我提供的【剧本/小说片段】,将其拆解为一份详细的、适合 AI 视频制作的分镜脚本表格。

Requirements:

- 转化逻辑: 将文学描写转化为可视化的镜头语言,严禁出现“心里想”等无法拍摄的描述,必须转化为动作或微表情。

- 格式要求: 输出为 Markdown 表格,包含列:分镜号、景别(远/全/中/近/特)、镜头运动(推/拉/摇/移/跟随/固定)、画面内容(详细描述主体、环境、光影)、音效/台词、预估时长(秒)。

Input: [在此处粘贴你的剧本内容]

拿到 AI 给出的初版表格后,绝对不能直接使用。

AI 生成的分镜往往只是逻辑通顺,但缺乏“电影感”。这时候就需要调用你的视听语言积累了。你要在脑海中不断预演这些画面,看它们衔接起来是否流畅,节奏是否拖沓。

为了解决这个问题,我们需要对分镜进行“二次优化”。针对短剧的快节奏特性,我将前面所学的镜头组接原则(如动接动、30度规则、匹配原则等)提炼成了一套大模型能听懂的结构化指令。

你可以把初版分镜再次发给 AI,如果需要包含上述原则优化分镜的提示词可以文末扫码进群领取。

如果你只是初学者,画面感没有那么强,可以按照上述的提示词来进行优化。但随着大家阅片和做片的增多,一定要有意识地去在脑海中预演,进行人工修改。

当这一切准备就绪,你获得了一份经过 AI 拆解、又经过自己优化的分镜脚本后,我们就可以进入下一步的制作了。

但一定要记住,分镜脚本绝不是一成不变的,它的改动会贯穿于你制作的全流程。在后面生成图片或视频时,你可能会发现某个原本设计的镜头效果并不好,或者 AI 跑出了一个意外惊喜的画面,这时你都要随时回到这一步来调整分镜。

如果你是一个把握全流程的人,那你就是导演,你要做好随时修改随时沟通的准备。

二、角色设计

如果分镜脚本已经确定得差不多了之后,就要开启后续的角色、场景设计了。主要还是角色设计。

如果大家已经在AI聊天窗口中优化好了分镜脚本,那么就可以直接对着它说:

🍞

请你仔细研究我的分镜脚本,请你为我设计其中出现的角色的人物定妆照的AI绘画提示词。 背景为纯白背景。要包含人物外貌长相、服装、发型等等。中英文各一版。画风为2D动漫风格。

注:如果甲方已经提供了完整的分镜脚本了,那就先把分镜脚本直接上传到Gemini等工具当中,再按照上面的提示词来要求AI生成角色形象提示词。

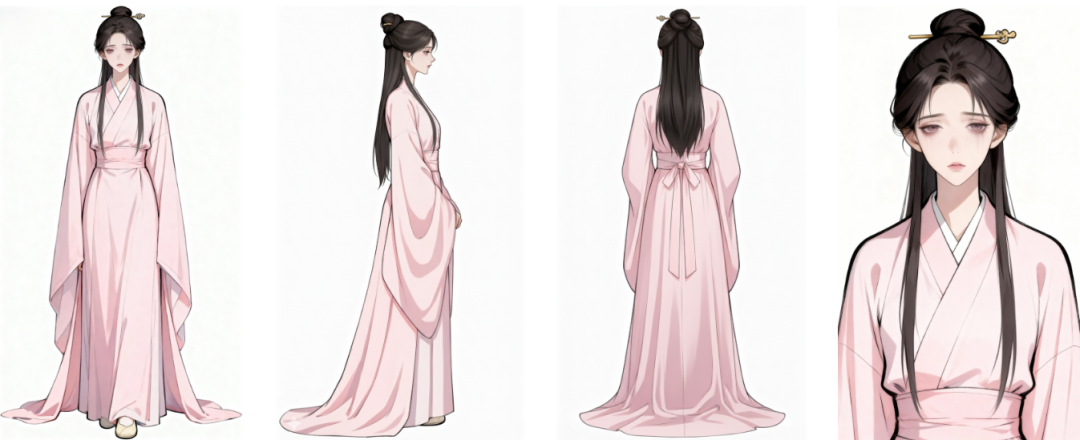

跟编剧沟通过后,我们所需要创建的角色形象为6个,涉及到的形象造型有10个。

姬花燃:古代异族女子的形象,身穿斗篷

老者:古代异族中年男子的形象,身穿斗篷

慕云尽:古代年轻将军的形象 慕云尽(战损版):古代年轻将军的形象,盔甲残破,发髻凌乱,带有血迹

萧澜月:古代女子,红色嫁衣,披头散发,带有血迹

萧澜月(濒死):古代女子,粉色常服,面色惨白

玉琼筝:温润如玉的古代男子形象

玉琼筝(血迹版):温润如玉的古代男子,带有血迹

公子瑾:古代贵公子形象

公子瑾(龙袍版):古代年轻帝王形象

以上这些都是人设,一定要提前沟通好,场景也都是古代的场景。

拿前两个角色姬花燃和老者来举例:

姬花燃和老者只会出现在第一幕,作为与天对弈、操控棋局的存在,不能是传统的汉族服饰和样貌,得带有一些异族色彩。因此在跟AI聊的时候,我们也要把这些人设告诉AI。

于是AI给我了这样的提示词:

姬花燃

2D动漫风格,一位古代异族女子,全身形象。她约莫二十岁出头,高高的鼻梁,面容清丽,皮肤白皙,眼神深邃而坚定。一头乌黑的长发自然垂落,部分发丝用异域风格的编发束起,佩戴有特色的小巧银饰。身穿一件深色斗篷,材质厚重,边缘有简洁的刺绣纹样,内搭异族风格的素色长裙。纯白色背景。

老者

🎨

2D动漫风格。全身构图,正面构图,一位四十岁左右的古代异族男子。他面容沉稳,眼神睿智而深邃,鼻梁高挺。身穿部落风格的深色长袍,外披一件厚重的暗色斗篷,斗篷边缘有简朴的图腾刺绣。他手中持握着一根华贵的、顶端镶嵌着宝石或兽骨的巫杖,显得神秘而有力量。纯白背景

我们之前的文章分享过大家如何一次性生成一个这样的正面+三视图的提示词模板。

🌟

生成全身三视图以及一张面部特写。(最左边占满 1/3 的位置是超大的面部特写,右边 2/3 放正视图、侧视图、后视图),纯白背景。+“人物外貌描述”

我们其实也可以先生成人物的正面全身构图后,再依次生成侧面、背面、近景图。 比如,当我们已经生成好满意的角色正面全身照之后,直接把它上传到即梦AI当中,依次说要生成侧面/背面/近景即可。

这里为什么分多次生成正/侧/背面图?因为使用不同的工具,我们有不同的玩法。

AIpai等Agent当中,一个角色ID最好是对应1张图片,我们当然尽可能地将不同视角的图放在一张图中。

而对于Vidu、可灵这些AI视频网站,本身自带主体库功能,往往能够上传多张图片作为同一个角色,因此我们可以把不同视角的角色图分别上传上去。

其余角色也是通过如此操作来生成不同视角的图片,也可以仍然按照前面教的那样做成整张三视图,取决于你的使用平台。

值得一提的是,大家不要觉得AI给你的人物角色提示词是一次性就能到位的。不要去省这个时间,前期对角色的精雕细琢是有必要的。在美观的同时,尽可能地符合剧本的设定及甲方的需求。

与编剧沟通后,我们针对每个角色的提示词进行优化,这个过程要人为地去不断尝试,比如说服装发型和整个人物的气质。

在发型上,古代男子通常二十行冠礼后便会束发,像慕云尽这个将军形象的角色,一定得扎着发髻,又不能太过华丽,因此不要有发簪。

玉琼筝的人设是江湖名医,整体气质偏病娇,也有种江湖隐士的感觉,他的发型可以是发髻+披发。

潇澜月有两场戏,大婚之日家破人亡遭人陷害沦为阶下囚,因此第二幕的设定是她穿着一袭残破的红色嫁衣,披头散发,钗环都掉了。

公子瑾作为皇室成员,日常装扮要贵气,可以有玉簪,深色汉服带有金纹。作为幕后之人,他眼神可以带一点阴翳。

潇澜月的第四幕,是塑造她的弥留之际,不施粉黛,一脸病态,着装也是十分浅的粉色日常汉服。

公子瑾在最后一幕已经登基称帝,此时的他应该穿着龙袍,头戴冕旒/冕冠。

前期的沟通到位,角色定稿相对比较顺利,各方都通过之后就可以进行下一步的分镜制作了。

三、出图出视频

出图与出视频紧密相连,出图实则是为出视频服务。在此部分,我们将对本片在出图及出视频方面的一些关键技巧展开拆解。

过去,纯图生视频工作流的惯常做法是,针对每个分镜,都使用单独的提示词生成图片,之后再逐张由图生成视频。然而如今,相较于一年前甚至半年前,模型与工具都取得了巨大的进步。诸多流程得以优化,制作难度与门槛大幅降低。

本片制作于10月,当时诸如Nano Banana pro、可灵O1、即梦4.5、海螺2.3、Wan 2.6等模型均未发布。与模型百花齐放的11 – 12月相比,那时在出图改图方面的难度要大得多。我们较多依赖的工具是即梦、Vidu、可灵、海螺以及PS。

鉴于甲方要求呈现国风 2D 动漫风格,就目前而言,契合国人审美且适用于此类风格图片的模型当属 Seedream 4.0,也就是即梦 AI 中的即梦 4.0 模型。与 Midjourney v7 等传统绘画模型相比,它对中国古装造型、服饰提示词的理解更为出色。当然,大家也不妨尝试各类开源绘图模型,liblib、星流、runninghub 等平台上有不少相关工作流,在此就不做演示了。

通常情况下,即梦AI对我们来说已能满足需求。

谈到出图,我们首先得梳理清楚,究竟哪些图是必须要出的。

为何要思考这个问题呢?这是因为如今视频模型愈发强大,像 Vidu q2 的参考生视频、Sora 2 的角色参考,以及近期刚发布的可灵 O1、Wan 2.6 等视频模型不断升级迭代。许多分镜现在已能通过 “图生视频 + 视频截帧再优化” 的方式获取,甚至能够直接利用角色参考生成视频素材。如此一来,许多视频素材都无需先出图,再生成视频了。

过去,我们费尽心思出图,目的无非是为了精确把控视频中角色、场景以及风格的一致性。随着工具和手段的不断更新,我们自然也得持续优化自身的工作流程。

1、直出分镜图

回到刚才所提的问题。对于那些不包含人物的空镜头、较为抽象的镜头,或者是远景、全景这类镜头,我们都可考虑运用传统的提示词直接生成的方法,预先完成出图。

这些镜头,往往不会包含太复杂的人物动作、站位,基本都是为了展现环境氛围,相比较视频动效,对于画面整体的美感要求会更高一些。论画面的精细度,图像模型肯定要比视频模型更好。况且事先生成好的场景,也可以用于后续的参考生视频当中。

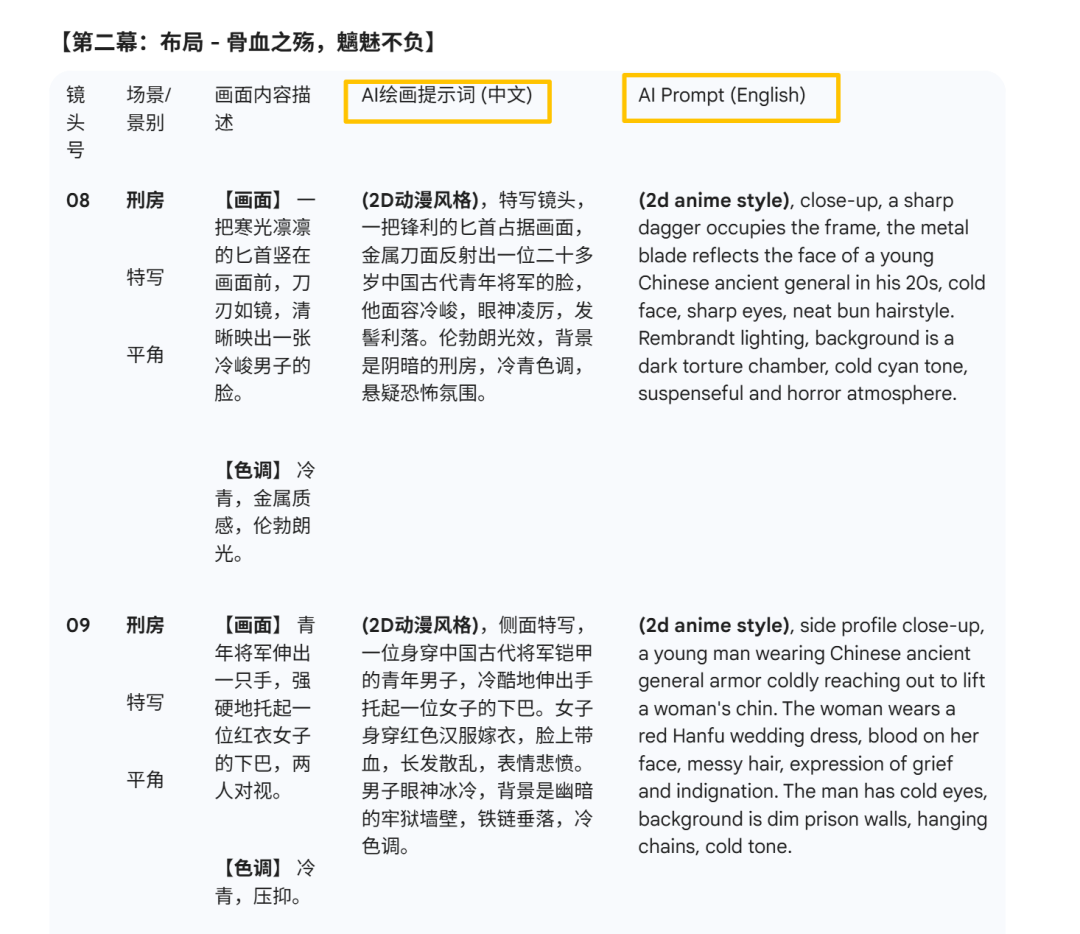

1)AI 辅助生成分镜提示词

继续在生成分镜脚本的那个聊天窗口里,我们要把需求清晰地罗列出来,让 AI 协助我们构思所有分镜的提示词。此刻,先不用去区分哪些图用提示词直接生成,哪些不需要,先让 AI 把提示词都给我们罗列一遍。

AI 给出的提示词,应该要素完备、指代明确。大家既可以依照下面的提示词模板与 AI 沟通,也能够依据自身的详细需求对下面的模板进行优化:

💡

请回忆前面的最终版分镜脚本表格。对照表格内容,将每个分镜图的ai绘画提示词给我,也列入到表格当中。 注意: 1、提示词要包含场景、景别、镜头角度、画面内容、整体色调等。 2、不能只是把分镜表格里的内容进行简单拼贴,你还要根据前后逻辑,合理地延伸。 3、每个分镜,提示词里不能只通过名字指代人物角色,包含具体角色的,要通过具体的提示词来描述他的外貌特征, (每个分镜中相同的角色的外貌提示词要保持一致)。 4、每个分镜都将由AI绘画模型独立生成的图片,AI不懂各分镜的上下文联系,你撰写的提示词要避免出现针对上一个分镜的指代描述,例如“还是之前那个XX” “那个女人” “上一个分镜中的XX”等,每个指代物都要通过提示词描述清楚。

5、出图的目的是为后续视频生成做铺垫。因此,当你依据分镜的视觉描述撰写提示词时,需思考生成何种图片,应当是提示词所描述动作发生之前的画面。 6、提示词中英文各一版。 7、风格都为2d动漫风格。 8、各角色的外貌提示词如下:(前面与AI聊天过程中确定的提示词) 角色A:XXX 角色B:XXX

注:第6点准备提示词的中英文各一版,目的在于方便大家,若想在 Midjourney、Stable Difffusion 等工具中使用相关图片时,能直接适用。第8点是为了防止AI忘记了前面的内容,才把主要角色的一些主要外貌服饰特征再重新罗列一下。

可以看到,AI帮我把每一幕的每个分镜的AI出图提示词中英文提示词都罗列出来了。

2)即梦和Midjourney对比

对于本片而言,开篇的星河棋盘,就是一个很抽象的画面。肯定是用提示词直出效果是最好的。

下面的提示词就是我在AI的初版提示词的基础上进行的优化,给大家看看即梦和Midjourney各自的效果:

2D动漫风格,超现实意境。平视构图。一只肤色健康白皙、比例完美的男性手掌特写,从画面上方的虚空悬浮而下,停留在古朴的圆形棋盒正上方,指尖微张,蓄势待发,准备拈取棋子。棋盒内盛满了乌黑圆润的黑色围棋子,棋盒旁边隐约是一个无边无际、抽象的棋盘。棋盘由深邃的星河倒影构成,没有明显的实体边框,边缘隐约与抽象的山川河流相接,仅有其广阔的表面清晰地反射着璀璨星光。虚空宇宙背景环境,浅景深,整体色调为深邃的青黑色,星河微光是主要光源,营造出一种超然、神圣而富有东方美学的创世瞬间。

对比还是很明显的,同样的人物角色提示词也拿出来进行对比:

相比较而言,Midjourney 的风格化较为浓烈,整体风格更偏向艺术。它对于棋盘、围棋、汉服等这类中国风元素的理解程度,相对没那么理想。

因此,经过前面角色设计环节,以及后续分镜出图的多轮测试,我们依旧决定使用即梦AI来作为本项目的主要出图工具。

3)角色参考+提示词保持一致性

对于一些角色动作相对简单的图,也可以用提示词+角色参考图来直出。

当时的即梦4.0在参考角色生图方面,效果已经很不错了,现在的即梦4.5效果更好。

上传姬花燃和老者的单人正面构图参考图,然后在提示词中描述:

景别、构图、风格都理解得非常到位。人物的一致性也保持得很不错。

4)远景及大场面

对于那些不包含人物的空镜头、或者是大远景、全景这类镜头,我们也可以优先考虑用提示词直接生成图片。

因为这类镜头通常没有复杂的人物表演,它们的核心任务是展现环境氛围和画面美感。就目前的 AI 技术而言,在画面的精细度、光影质感和构图审美上,专业的绘图模型依然是吊打视频模型的。

视频模型为了保证动态的流畅,往往会牺牲掉背景的细节纹理。而我们用绘图模型先把这些大场面生成出来,不仅能获得一张壁纸级的高清原图,还能把它作为后续图生视频的“底图”,保证视频的清晰度。

比如片中“雷劈观星台”这一幕,这是一个典型的大远景。画面主体是险峻的山巅和雷电,人物只是两个渺小的剪影。如果直接让视频模型生成,山石的纹理和雷电的光效很容易糊成一团。

我在即梦中输入如下提示词:

大家看这张图,闪电撕裂夜空的质感,以及观星台在逆光下的剪影轮廓,都非常清晰且富有美感,这种级别的画面是目前视频模型很难直接跑出来的。

5)特殊构图

对于一些构图较为特殊的分镜,利用提示词直接生成能够实现更精细化的效果。

比如,有这样一个特写镜头:以POV视角,镜头聚焦在一个男人身上,他看着手中的匕首,匕首反射出照在男人脸上的光。此时,只需上传角色图片,再详细描述提示词,就能得到这样的构图。

2、复杂镜头的连贯性与分镜衍生

搞定完简单的画面后,剩下的往往是那些需要强烈运镜感、想要呈现一镜到底效果的复杂镜头;又或者需要在多个连续镜头中保持高度的连贯性。

针对这两种情况,单纯靠写提示词去盲盒抽卡,效率极低且很难保证连贯性,我们需要借助 AI 工具,对画面进行更精细的控制和衍生。

首先是针对一镜到底的长镜头或大动态运镜,核心在于首尾帧的巧妙运用。

过去我们在使用这个功能时,往往单纯通过提示词来控制:独立生成一张首帧 A,再独立生成一张尾帧 B,然后强行让 AI 去计算中间的过程。但如果 A 和 B 的背景透视或人物姿态差异过大,AI 算出来的中间过程往往会崩坏,因为 AI 无法理解两个逻辑不通的画面该如何过渡。

这里有给大家介绍两种常见的解决办法:

1)原图重绘

第一种是原图重绘法,它适用于镜头机位基本不变,但画面主体发生变化的场景。

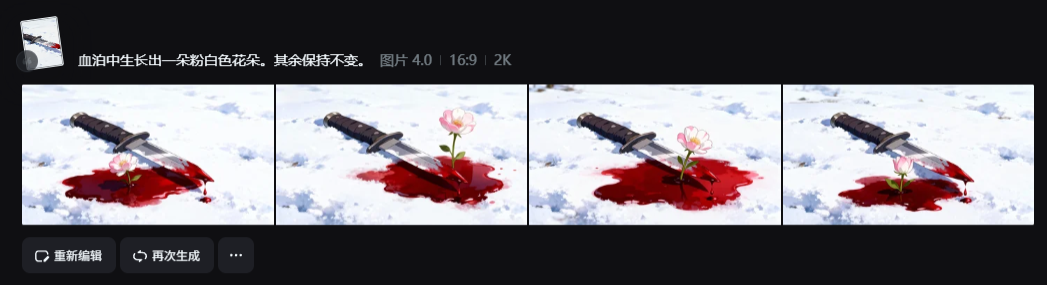

比如片中有一个镜头:一把带血的匕首掉落在雪地里,随后血泊中生长出一朵粉白色的花。

这种画面如果分别单纯用提示词来直出两张图,雪地的纹理和匕首绝对会对不上。生成出来的视频,虽然以现在的模型技术,也能做到丝滑渐变,但背景、物体有会发生变化,这种变化肯定是不符合剧情需要的。

在这种情况下,就只应改变需要变动的元素,对于诸如背景、匕首样式等无需改变的元素,必须把控好一致性。

我们先用提示词直接生成中间这张带血匕首落地的图片,而前后两张图,则借助即梦、豆包、Nano Banana,甚至是 PS 进行局部调整。

调整好后,我们只需要让这三张图首尾相接,分别生成两段首尾帧视频素材,即可无缝拼接成一个匕首落地、流血、开花的素材了。因为图1和图3是直接在图2的基础上修改的,周围的雪地、光影、构图与图2是像素级对齐的。把这两张图喂给视频模型,AI 只需要专注于计算“花朵生长”的过程,生成的视频自然丝滑无比。

此后,我期望画面外的玉琼筝弯腰摘下这朵花,拿起并端详。此时,画面只需保证这朵花的一致性,背景大致呈现雪景即可。

那么,我们可以上传前面那张开花的图、玉琼筝的全身照以及近景照,接着,提示词这样写:

🎁

2D动漫风格,干净的线条,近景。参考图中的男人,一只手捏住图1中的粉白色花朵的花茎。背景为野外的雪景,整体色调为纯白色。

得到两张图后,再通过首尾帧来控制,输入提示词,生成摘花的视频,就很丝滑了。

镜头跟随着一只修长的手伸入画面,将花朵摘下。手的主人是一位身穿淡青色汉服长袍的青年公子。定格在尾帧。2d动漫风格。

而对于那些存在大动态运镜,以及背景透视关系发生显著变化的场景而言,如果画面之间的透视关系差异极大,那就需要确保首尾两帧图片中有一个十分明显的相同元素,比如某个角色、物品之类。这便要求我们妥善处理尾帧图,可借助 PS、Nano Banana、即梦等工具,给尾帧增添与首帧相同的元素。

例如,花瓣转场:

蝴蝶转场:

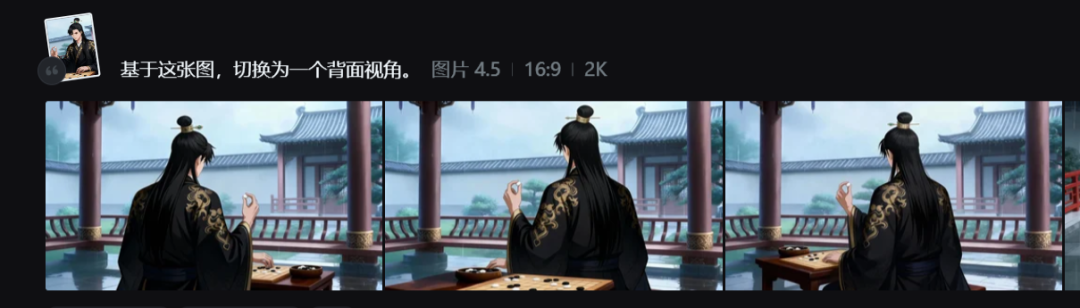

2)分镜衍生与视角重构

第二种技巧,我们称之为分镜衍生与视角重构。它侧重于解决机位发生改变时(切分镜),如何保持画面一致性的难题。

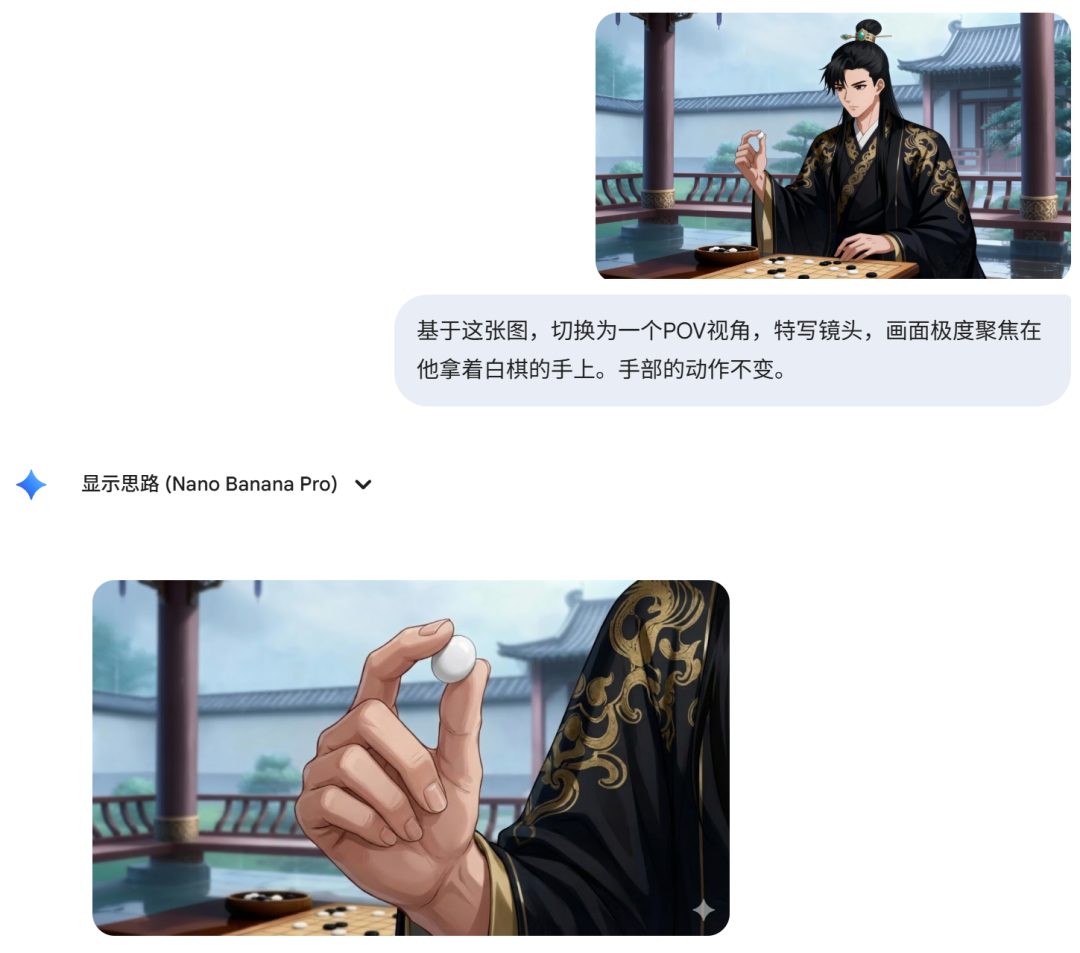

例如,前一个镜头是一个男人坐在棋盘前的中景,手里捏着一颗棋子;下一个镜头你想切成一个近景特写,聚焦在他捏着棋子的手上,甚至是切换成他的第一人称视角(POV)看着手中的棋子。

这种镜头组接,如果单纯靠写提示词去重新生成一张近景图,AI 的随机性大概率会让环境氛围、光影方向甚至人物衣服的褶皱细节发生突变,导致两个画面接在一起时非常“跳戏”。

最好的做法,是基于已有的那张完美中景图(母图),进行“衍生”。这里有两条路径,分别对应不同的难度。

首先是主流的“图片编辑法”,适用于机位变化不大、或者空间关系简单的切镜。

现在的图片编辑模型(如 NanoBanana Pro、阿里千问 Qwen-Edit、即梦图片4.5)已经非常强大。如果你只是想把全景变成中景,或者把中景变成特写,或者在当前视角下稍微移动一下构图,直接把原图扔进这些工具,通过简单的提示词指令,就能在保持原图特征不变的基础上,单纯改变画幅或焦段。这种方法精度极高,且不会损失画质,是目前处理简单分镜切换的首选。

但是,图片模型有一个明显的局限性:空间想象力不足。

当你面对高难度的角度切换时,比如过肩镜头,或者希望把机位从人物正面切换到侧后方,图片模型往往只能做到把“人物”转过去,但背景的透视关系依然纹丝不动。这就导致画面看起来像是人物在一个纸片背景前转身,非常违和。

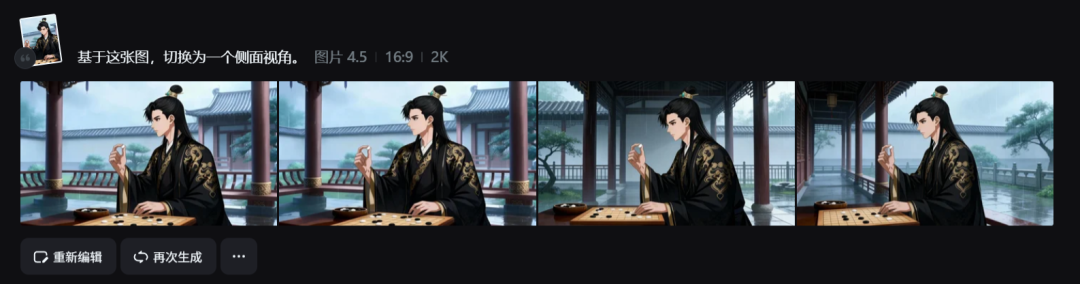

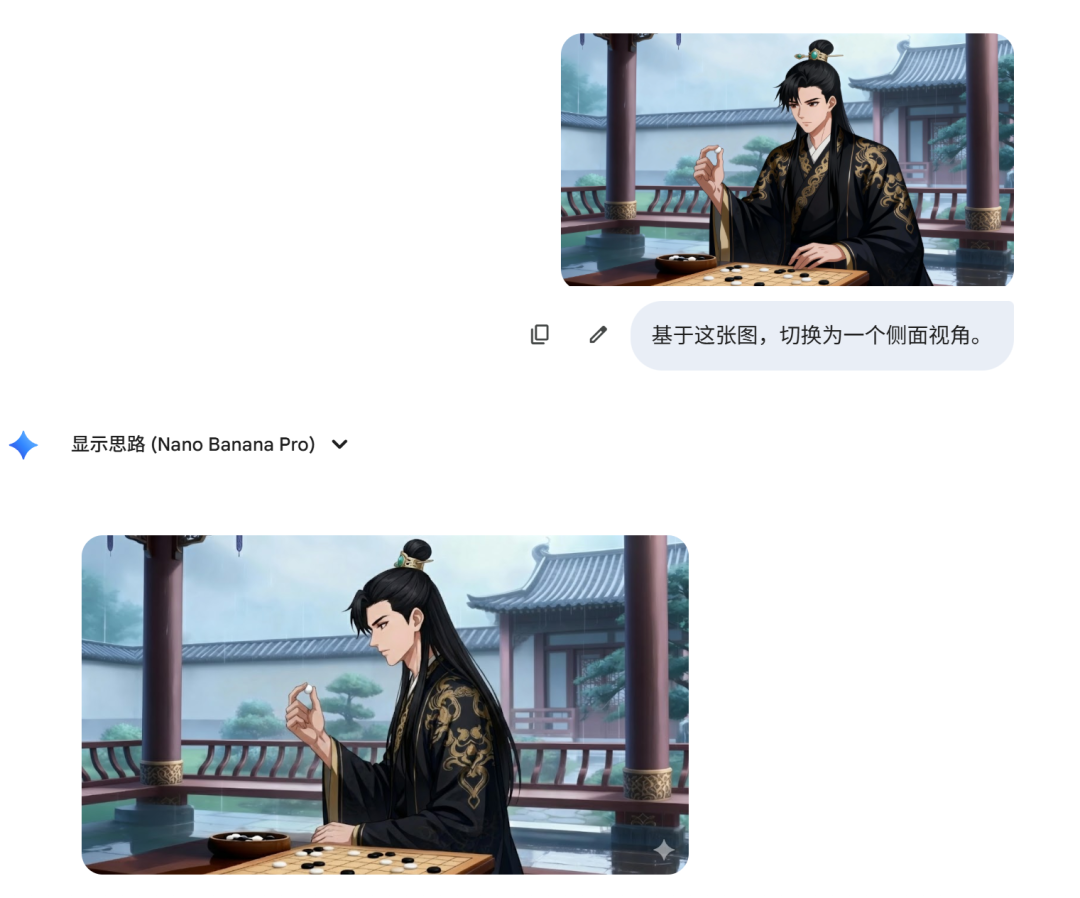

可以看到,不论是即梦还是Nano Banana pro,对于这种背景复杂的画面,我要切换背面、侧面视角的时候,基本都只是把人物切换了,但背景依旧保持不变。

又或者,我希望呈现男人的POV视角(第一人称视角)下观察手中的棋子的特写镜头,这个对画面的转变就更大了,不是简单的镜头推进那么简单。

可以看到,不论是即梦还是Nano Banana pro,都出不来我想要的第一人称视角下手捻棋子的特写镜头画面。

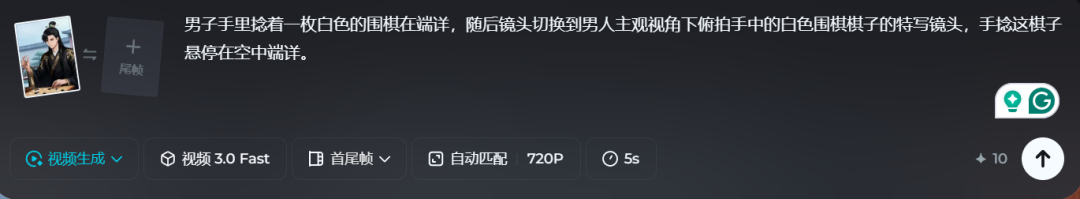

这时候,就可以利用视频模型来重构视角。

视频生成的底层逻辑是建立在对物理空间理解之上的。当你需要大幅度改变机位,或者进行复杂的视角切换(如第三人称切第一人称 POV)时,我们可以拿已经确认好的原图作为底图,扔给视频模型,输入一个运镜指令(比如“镜头推进至手部特写”或“切换至第一人称视角”),让 AI 先跑一段视频出来。

即梦、万相、Sora等视频模型都有切分镜的功能,而可灵、海螺那些模型实测下来没法切分镜,只能通过运镜来改变景别和视角。

以即梦AI来举例,我们把男人手捻棋子的中景图上传到图生视频之后,选择3.0以上的视频模型都可以,然后输入下方的提示词,最后生成效果如下:

可以看到,视频的第三秒就已经成功切换到男人的POV视角看棋子的画面了。

虽然这个初版视频中,人物或者环境细节可能会有一点变形,但视频模型是基于原图的物理空间去演算新视角的,所以它生成的画面,在环境氛围、光影逻辑和背景的透视延伸上,与上一镜基本能够保持连贯。

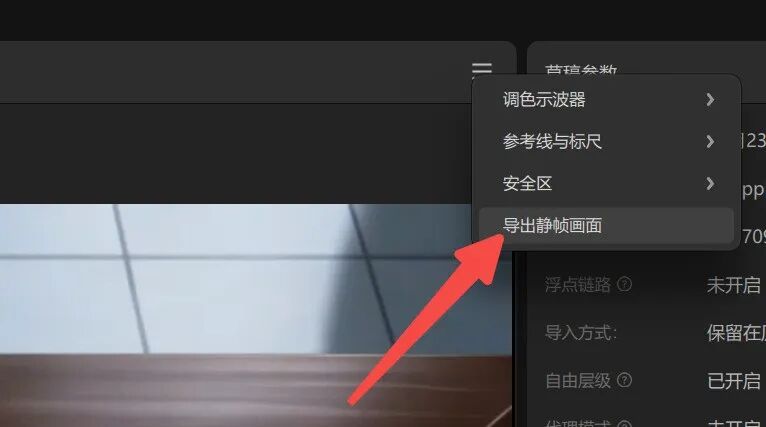

如何截取呢?把视频素材导入到剪映等剪辑工具中,找到最满意的一帧,在右上方选择导出静帧画面即可。

我们只需要在生成的视频中截取那个最满意的帧,把它作为底图,再丢回图片工具里稍微精修一下细节,或者使用PS等工具来优化,就能得到一张透视完美、逻辑自洽的下一镜画面。

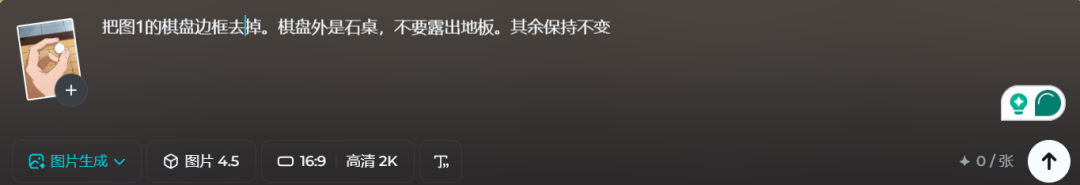

比如截取下来的这张图虽然视角是正确的,但画面中的细节还是有问题,譬如棋盘上对应的位置中应该有花瓣,棋盘不应该有边框,且画面中出现了现代风格的地板砖,这些都是画面的缺陷。

继续在即梦等工具中来用AI改图,首先把棋盘下方变成石桌,去掉地板。

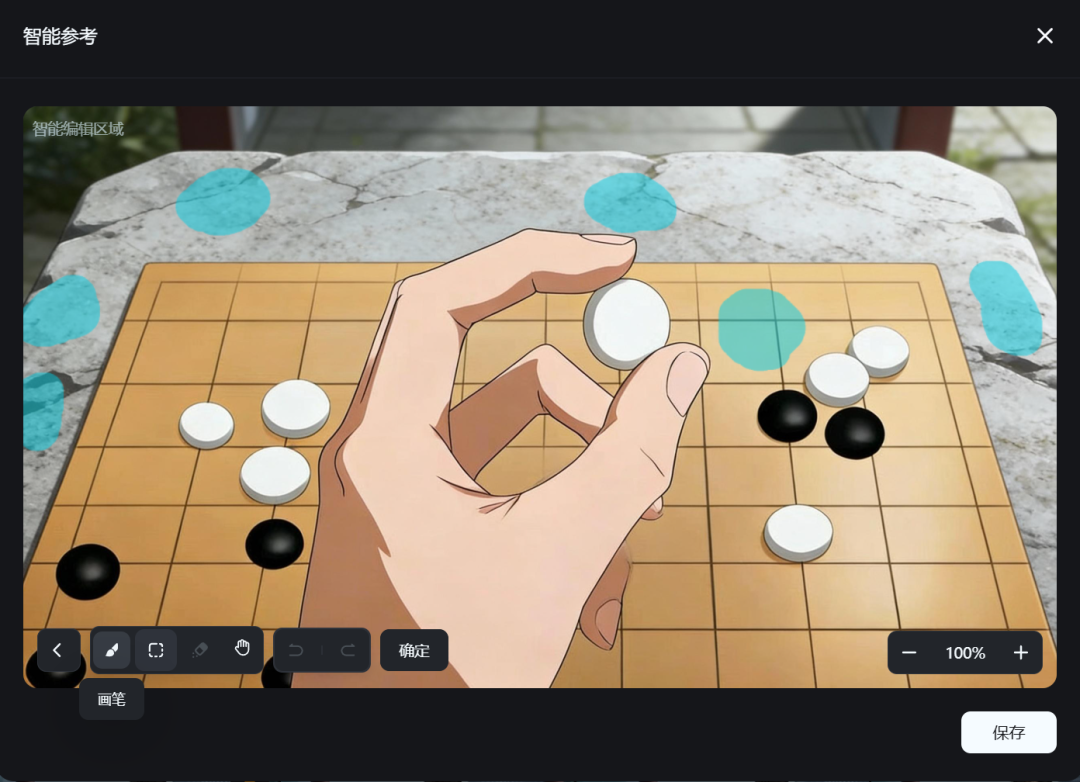

然后继续上传到即梦中,点击一下图片的缩略图,设置智能参考区域。可以用画笔在图片上需要修改的位置进行涂抹,然后在提示词中输入“在棋盘上的涂抹区域放上粉色的花瓣,其余保持不变”。

经过这么一个流程下来后,我们就能够得到一个非常流畅的连续分镜: 近景-花瓣飘落到棋盘的 ➡️ 中景-男人从棋盒拿取一颗棋子 ➡️ 特写-POV视角下观察手中的棋子

不难看出,下方的几张图,也是通过视频模型来截取分镜,再去进行的优化,步骤类似,便不赘述了。

3、参考生视频

这是目前 AI 视频工作流中最高效、也是最能解放生产力的一环。它的核心逻辑是:彻底跳过“分镜出图”这一步,直接用角色 ID 演戏。

随着 Vidu 等模型推出了“主体参考”功能,我们不再需要为每一个复杂的交互镜头去痛苦地抽卡画图。只需要将之前设定好的“角色三视图”或标准照上传到主体库,再上传一张背景图,剩下的就全部交给提示词。

这在处理多人互动或高难度动作时优势巨大。比如片中需要表现“两人激烈的打斗”或者“细腻的情感拉扯”,这类画面如果用绘画模型生成,很容易出现肢体穿模或神态僵硬。但通过参考生视频,我们可以直接描述动作逻辑,视频模型会根据对物理规律的理解,驱动你上传的角色 ID 在场景中做出自然的表演。

下方左侧是利用 Vidu 的参考生视频功能所生成视频素材的截图,右侧则是即梦 4.5 直接生成的图片。起初,我们尝试直接生成左侧的效果,期望呈现出左图这种过肩镜头画面 —— 慕云尽单手掐住潇澜月的脖子。

过肩镜头,不管是过去还是现在,都是一种实现难度较大的视角,抽卡率很高,即便现在用 Nano Banana pro 来修改图片,也往往需要多次尝试,而且最终效果也未必能达到最佳。

不难发现,运用相同的提示词,参考生视频直接达成了我想要的效果,还省去了图生视频这一步骤。反观直接出图,效果就差强人意了。

四、音乐设计

鉴于这是真实的商业订单需求,音乐方面应尽量采用有版权的原创音乐。在 AI 音乐工具中,效果最佳的当属 Suno。

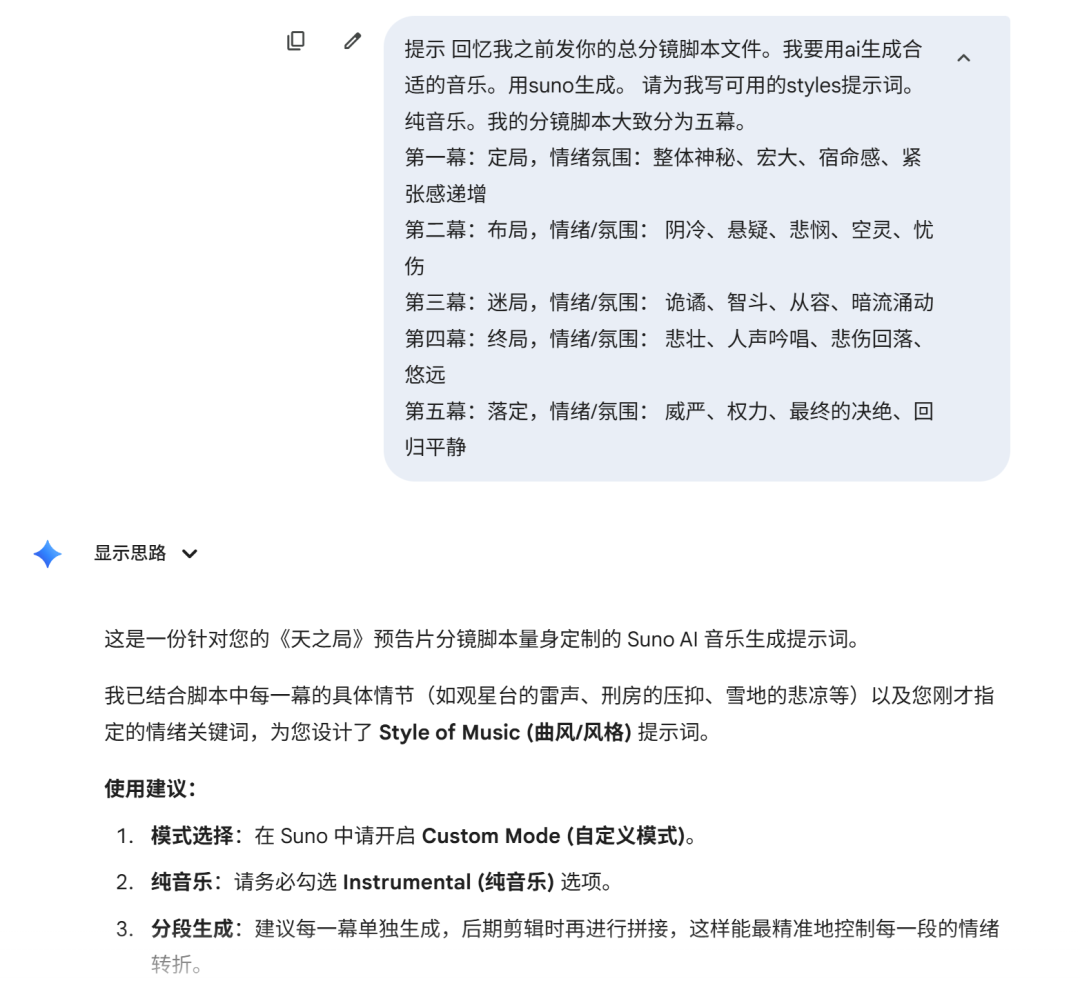

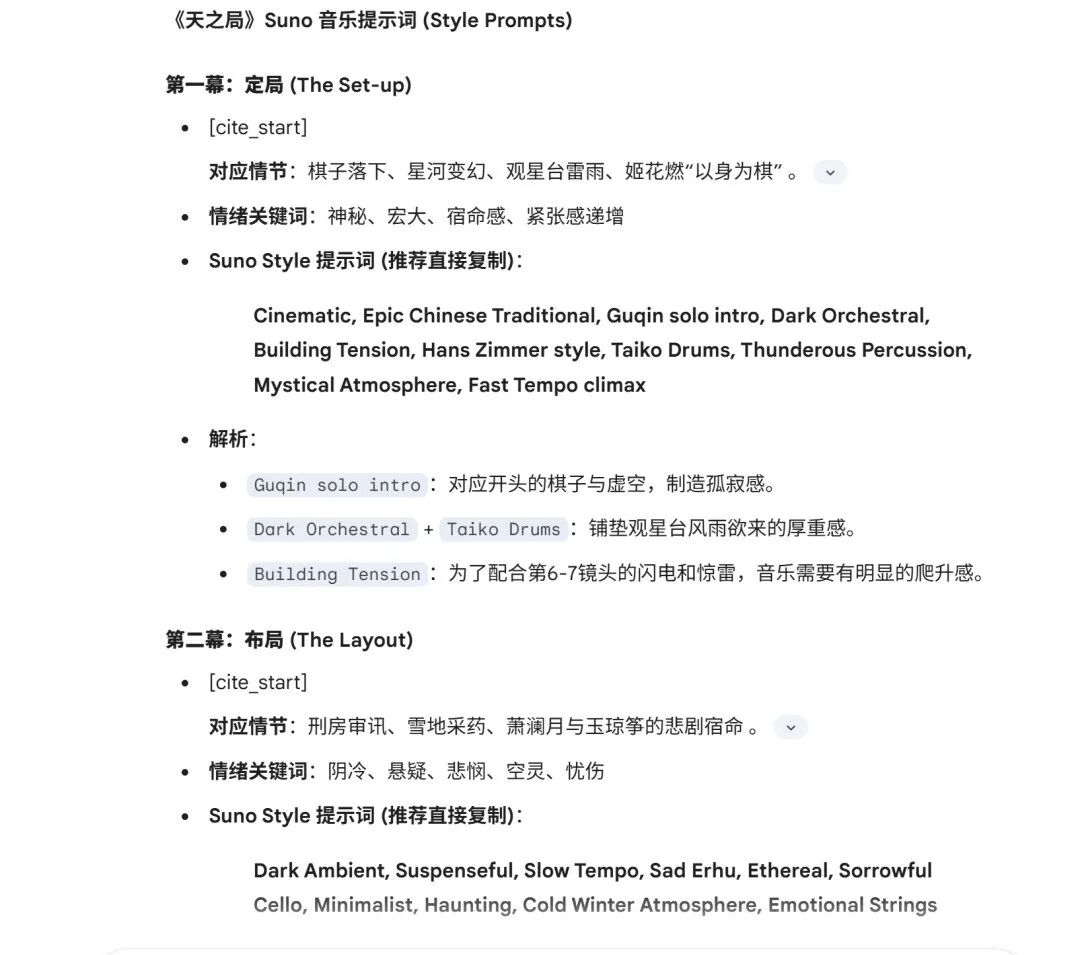

Suno 的使用方法在之前的公众号文章已有详细阐述。倘若已有完整的分镜脚本,可直接让 AI 针对分镜脚本内容进行分析,为你生成契合的 Suno 风格提示词。

制作本片时,分镜脚本已然完备,于是我们直接与AI探讨本片的音乐需求。由于本片分为5幕,各幕之间联系并非十分紧密,且每一幕都有其独特的情绪氛围。所以,我依据每一幕的基调,结合脑海中预演的画面,提前与AI沟通确定了大致的情绪氛围词。

⚽

回忆我之前发你的总分镜脚本文件。我要用ai生成合适的音乐。用suno生成。 请为我写可用的styles提示词。纯音乐。我的分镜脚本大致分为五幕。

第一幕:定局,情绪氛围:整体神秘、宏大、宿命感、紧张感递增

第二幕:布局,情绪/氛围: 阴冷、悬疑、悲悯、空灵、忧伤

第三幕:迷局,情绪/氛围: 诡谲、智斗、从容、暗流涌动

第四幕:终局,情绪/氛围: 悲壮、人声吟唱、悲伤回落、悠远

第五幕:落定,情绪/氛围: 威严、权力、最终的决绝、回归平静

注:要是脑海中能浮现相关画面,那自然再好不过;要是没有,大家也可不写,直接让Suno帮你构思就行。

可以看到,Suno把每一幕的提示词都提供给了出来,并且给出了相关解析,这样我就能从中筛选和优化。当然,这一步对于一般没有音乐专业知识的人而言,不用做得如此专业,大家直接用提示词在Suno里“抽卡”就行,基本上抽几次就会得到很合适的音乐。

Suno生成的这几首曲子,选用了其中的三首。

第一幕选用的这首曲子作为定场非常合适。从听感上来说,它应该具有一种引路人的质感,不是一开始就狂轰滥炸,而是用一种宿命般的低语把观众拉进这个名为天之局的世界。

第二幕和第三幕,虽然这两幕场景跨度很大,从阴暗的刑房到看似雅致的庭院,但这首曲子那种持续不断的悬疑和压迫感,却很符合这两场的氛围,因此选用了同一首。

第四幕是情感的爆发点,呈现的是生离死别的悲壮感,生成的这首曲子气质很符合。而曲子后半段情绪变得更激昂,正好对应第五幕公子瑾登临高位、盖下玉玺的画面。于是第四幕和第五幕都选了这首歌,直接延续到结尾,贯穿后面两幕,直接解决了叙事断层的问题。

音乐选择其实并无太多技巧,关键在于大家要深入理解画面所传达的情绪。

在与 AI 多次交互的过程中,不断进行尝试。有时生成的一首曲子,仅有其中几十秒的片段与画面契合;有时一首曲子的不同片段,分别适用于影片中的不同画面。所以,这就要求创作者具备足够的耐心,细细品味并精心筛选。

五、结语

走完这一整套流程,最直观的感受可能是,AI 确实帮我们省掉了大量的重复劳动,但它依然没法代替我们做最终的决定。虽然现在的模型能快速出图、出视频,但要把这些零散的素材拼接成一个逻辑自洽、情感连贯的故事,核心还是在于创作者对视听节奏的直觉。

在实际操作中,我们其实扮演了筛选者和修正者的角色。AI 生成的内容往往带有一定的随机性,这就需要我们利用前面提到的审美和分镜意识,去判断哪个画面能用,哪个细节需要重打。

这种对细节的死磕,正是区分流水线作品与精品的关键所在。

工具越是强大,这种基于专业背景的判断力反而越显得不可替代。

所以,对于刚开始尝试全链路制作的朋友,我建议不要过分依赖某个特定的工具,而是要多花精力去理解镜头语言和剪辑逻辑。

即便未来 AI 模型再次进化,有各种各样一键成片的Agent涌现,甚至能直接理解复杂的指令,也建议你不要丢掉这种亲自上手的习惯。

技术每隔几个月就会翻新,但你通过实操积累下来的这套创作逻辑是通用的。只要这套底层逻辑在,无论以后工具进化到哪一步,你都能快速上手,创作出真正想要的内容。