2 月 12 日消息,刚刚,智谱正式上线并开源最新模型 GLM-5。

据介绍,GLM-5 是迈向 Agentic Engineering 的产物:在 Coding 与 Agent 能力上,其取得开源 SOTA 表现,在真实编程场景的使用体感逼近 Claude Opus 4.5,擅长复杂系统工程与长程 Agent 任务。

GLM-5 采用全新基座:参数规模从 355B(激活 32B)扩展至 744B(激活 40B),预训练数据从 23T 提升至 28.5T;构建全新的「Slime」框架,支持更大模型规模及更复杂的强化学习任务。

同时,GLM-5 还首次集成 DeepSeek Sparse Attention(稀疏注意力),在维持长文本效果无损的同时,大幅降低模型部署成本。

具体表现上:

在全球权威的 Artificial Analysis 榜单中,GLM-5 位居全球第四、开源第一。

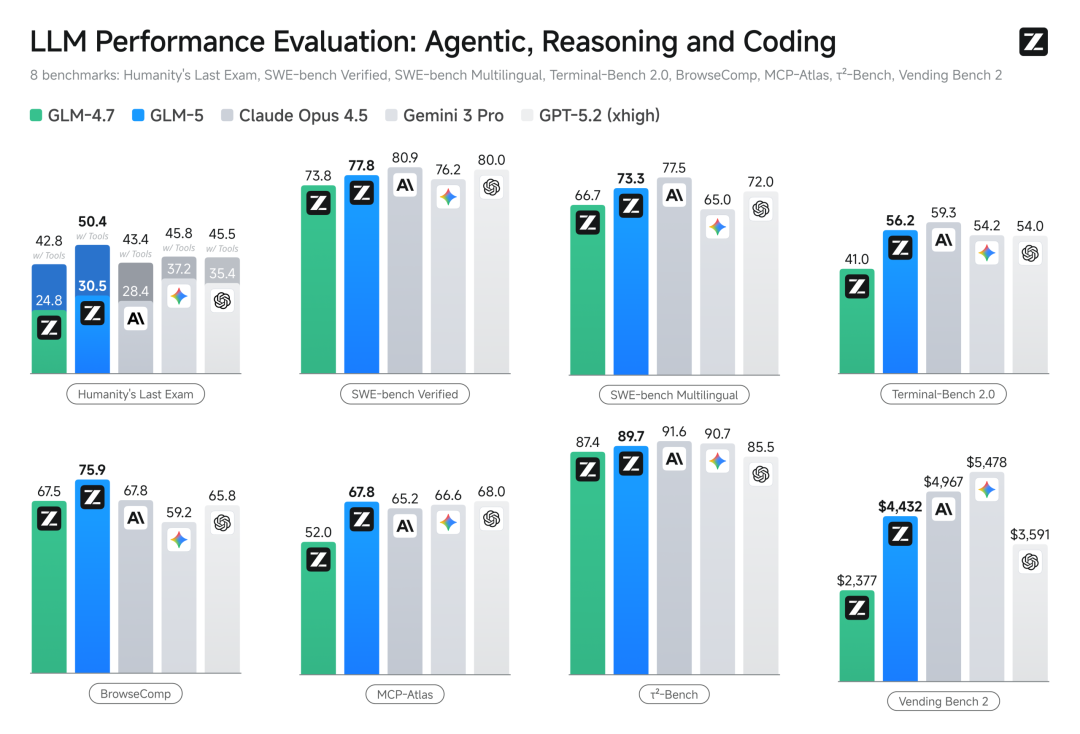

GLM-5 在编程能力上实现了对齐 Claude Opus 4.5,在业内公认的主流基准测试中取得开源模型 SOTA。

GLM-5 在 SWE-bench-Verified 和 Terminal Bench 2.0 中分别获得 77.8 和 56.2 的开源模型最高分数,性能超过 Gemini 3 Pro。

GLM-5 在 BrowseComp(联网检索与信息理解)、MCP-Atlas(大规模端到端工具调用)和 τ²-Bench(复杂场景下自动代理的工具规划和执行)均取得最高表现。

值得一提的是,目前 GLM-5 已完成与华为昇腾、摩尔线程、寒武纪、昆仑芯、沐曦、燧原、海光等国产算力平台的深度推理适配。通过底层算子优化与硬件加速,GLM-5 在国产芯片集群上已经实现高吞吐、低延迟的稳定运行。

即日起,GLM-5 在 Hugging Face 与 ModelScope 平台同步开源,模型权重遵循 MIT License。同时 GLM-5 已纳入 GLM Coding Plan Max 套餐。

在线体验

Z.ai:https://chat.z.ai

智谱清言APP/网页版:https://chatglm.cn

开源链接

GitHub:https://github.com/zai-org/GLM-5

Hugging Face:https://huggingface.co/zai-org/GLM-5